کارت گرافیگ انویدیا NVIDIA H100 80GB PCIe

برند و مدل: NVIDIA H100 80GB HBM2e PCIe GPU

کاربری: ورک استیشن، سرور، دیتاسنتر، HPC، Ai/DL/ML

- ریز معماری: معماری هوپر انویدیا – NVIDIA Hooper

- نام چیپ پردازنده گرافیکی: GH100

- تعداد هسته موازی کودا: 14592Shading Units

- هسته تانسور: 456Tensor Cores(Gen4)

- حافظه VRAM گرافیک: 80GB HBM2e

- پهنای باند حافظه: 2.04TB/s

- رابط حافظه: 5120bit

- عملکرد 26TF :FP64

- عملکرد 51TF :FP64 Tensor Core

- عملکرد 51TF :FP32

- عملکرد 756TF* :FP32 Tensor Core

- عملکرد 1513TF* :BFLOAT16 Tensor Core

- عملکرد 1513TF* : FP16 Tensor Core

- عملکرد 3026TF* :FP8 Tensor Core

- عملکرد 3026TF* :INT8 Tensor Core

- سیستم خنک کننده: Passive

- اتصال داخلی: NVLink (600GB/s) / PCIe Gen5 (128GB/s)

ارسال کالا: حدود 1تا 3 روز کاری(15 تا 35 روز کاری)

وضعیت محصول: آکبند(رنگی/خاکی/بالک)

گارانتی: تا36 ماه گارانتی.

سرویس طلایی دکمه ها: مهلت تست و برگشت 7روزه.

قابلیت ارتقا: تا چهار عدد در ورکاستیشن, هشت عدد در سرور.

*با پراکندگی (بدون Sparsity نصف این عدد)

۲,۲۹۰,۰۰۰,۰۰۰ تومان ۲,۶۸۰,۰۰۰,۰۰۰ تومان

کارت گرافیگ انویدیا NVIDIA H100 80GB PCIe

NVIDIA H100 PCIe 80GB

کارت گرافیک H100 PCIe 80GB یک کارت گرافیک حرفهای از NVIDIA در معماری هوپر (NVIDIA Hooper) است که در تاریخ ۲۱ مارس ۲۰۲۳ معرفی شد. این کارت گرافیک بر پایه فرآیند ۵ نانومتری ساخته شده و از تراشه پردازنده گرافیکی GH100 استفاده میکند. این کارت از DirectX پشتیبانی نمیکند. از آنجایی که H100 PCIe 80 GB از DirectX 11 یا DirectX 12 پشتیبانی نمیکند، پس نمیتواند بازیها را اجرا کند. پردازنده گرافیکی GH100 یک تراشه بزرگ است که مساحت تراشه آن ۸۱۴ میلیمتر مربع و دارای ۸۰ میلیارد ترانزیستور است. برخلاف H100 SXM5 80 GB که کاملاً باز است و از همان GPU استفاده میکند، اما تمام ۱۶۸۹۶ شیدر فعال است، NVIDIA برخی از واحدهای شیدینگ را در H100 PCIe 80 GB غیرفعال کرده است تا به تعداد هدف شیدرها برسد. این کارت دارای ۱۴۵۹۲ واحد شیدینگ، ۴۵۶ واحد نقشهبرداری بافت (texture mapping units) و ۲۴ واحد ROP است. همچنین ۴۵۶ هسته تنسور (tensor cores) برای بهبود سرعت برنامههای یادگیری ماشین در آن گنجانده شده است. NVIDIA برای این کارت ۸۰ گیگابایت حافظه HBM2e همراه با یک رابط حافظه ۵۱۲۰ بیتی در نظر گرفته است. این GPU با فرکانس ۱۰۹۵ مگاهرتز کار میکند که میتواند تا ۱۷۵۵ مگاهرتز افزایش یابد، در حالی که حافظه با فرکانس ۱۵۹۳ مگاهرتز در حال اجرا است.

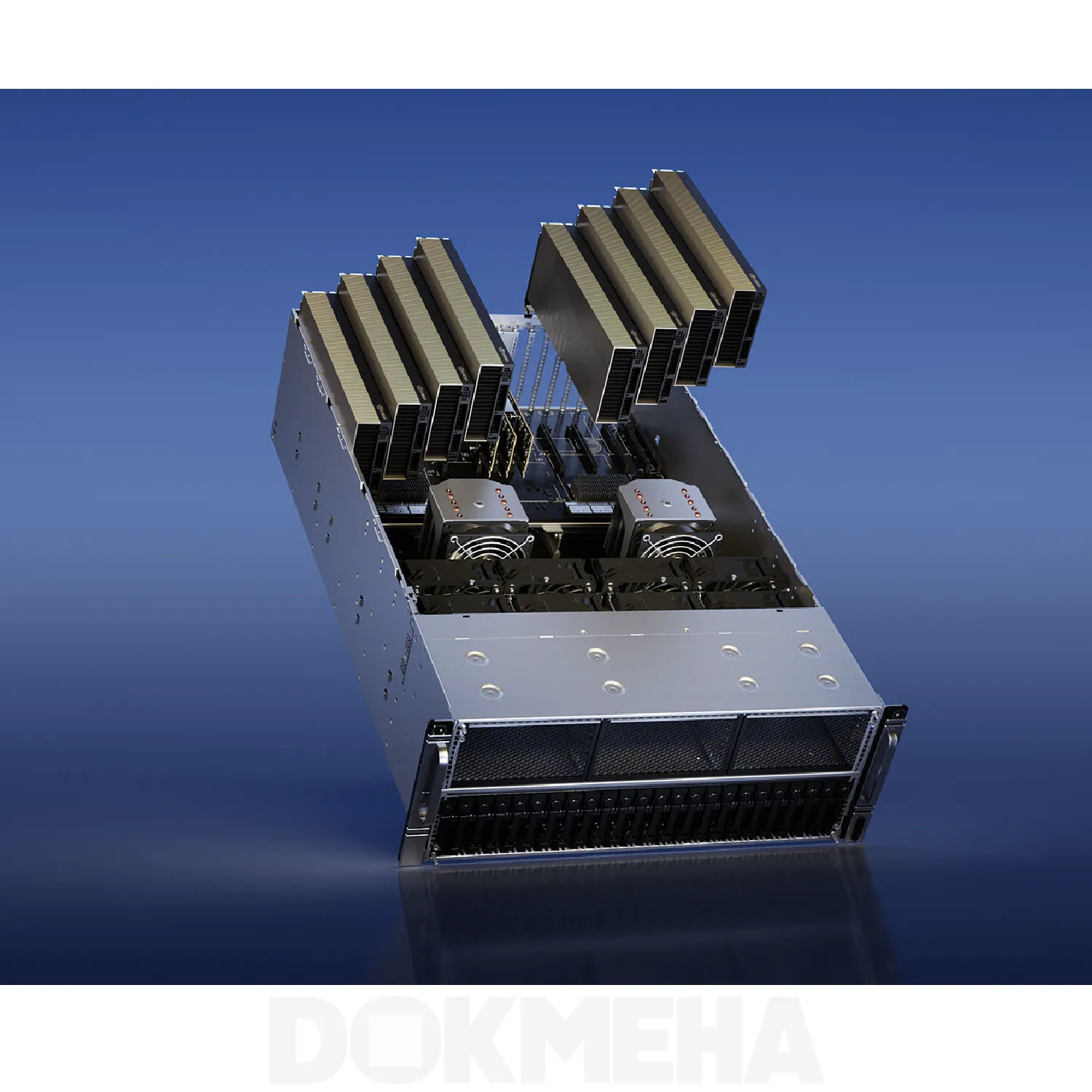

این کارت گرافیک دو شکاف (اسلات) را پر میکند و انرژی خود را از طریق یک کانکتور ۱۶ پین تأمین میکند که مصرف برق آن حداکثر ۳۵۰ وات است. این دستگاه هیچگونه اتصال نمایشگری ندارد، چرا که طراحی آن برای اتصال مانیتورها نیست. H100 PCIe 80 GB از طریق رابط PCI-Express 5.0 x16 به سایر اجزای سیستم متصل میشود. ابعاد این کارت ۲۶۸ میلیمتر طول، ۱۱۱ میلیمتر عرض و دارای سیستم خنککننده فعال نمیباشد.

NVIDIA H100 PCIe

عملکرد بیسابقه، مقیاسپذیری و امنیت برای هر مرکز داده

کارت گرافیک NVIDIA H100 Tensor Core یک جهش بزرگ در مقیاس AI (هوش مصنوعی) و HPC (محاسبات با عملکرد بالا) ایجاد میکند، با عملکرد، مقیاسپذیری و امنیت بیسابقه برای هر مرکز داده، و شامل مجموعه نرمافزاری NVIDIA AI Enterprise است که توسعه و استقرار هوش مصنوعی را ساده میکند. H100 بارهای کاری مقیاس اکساسکیل (Exascale) را با موتور اختصاصی Transformer Engine برای مدلهای زبانی LLMs با تریلیون پارامتر تسریع میکند. برای کارهای کوچکتر، H100 میتواند به تقسیمات MIG (Multi-Instance GPU) با اندازه مناسب تقسیم شود. با استفاده از Hopper Confidential Computing، این قدرت محاسباتی مقیاسپذیر میتواند برنامههای حساس را بر روی زیرساختهای اشتراکی مرکز داده ایمن کند. گنجاندن NVIDIA AI Enterprise در خریدهای H100 PCIe زمان توسعه را کاهش داده و استقرار بارهای کاری هوش مصنوعی را ساده میکند و H100 را به قدرتمندترین پلتفرم مرکز داده AI و HPC انتها به انتها (End-to-End) تبدیل میکند.

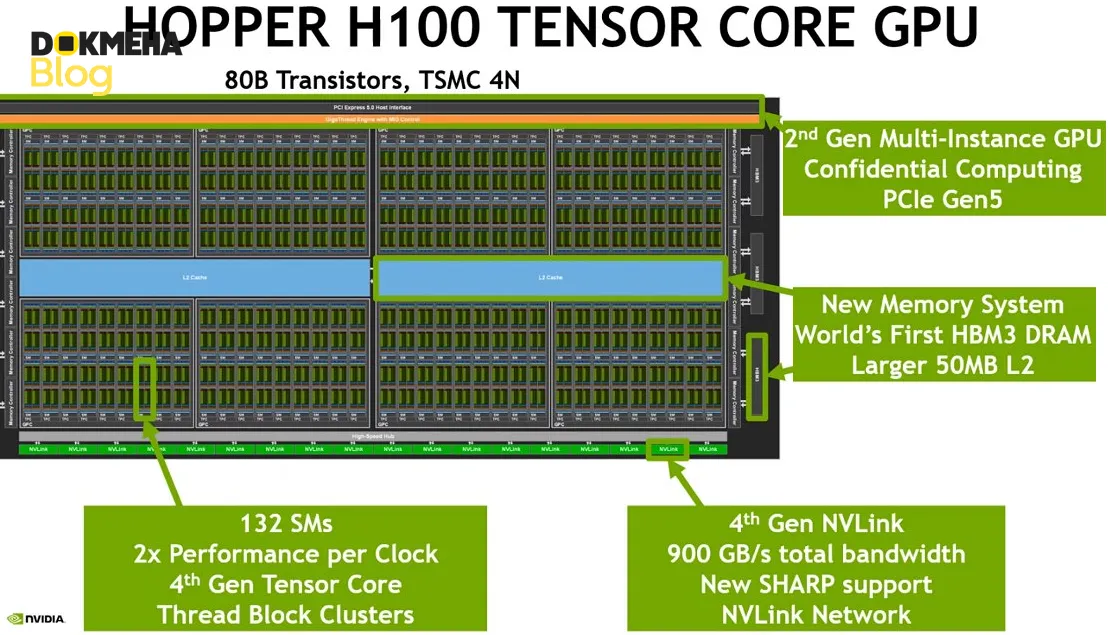

معماری NVIDIA Hopper عملکرد، مقیاسپذیری و امنیت بیسابقهای را به هر مرکز داده ارائه میدهد. Hopper بر اساس نسلهای قبلی از قابلیتهای جدید هسته محاسباتی، مانند Transformer Engine، تا شبکهسازی سریعتر ساخته شده است تا مرکز داده را با سرعتی یکسویه نسبت به نسل قبلی تقویت کند. NVIDIA NVLink پهنای باند فوقالعاده بالا و تأخیر بسیار پایین را بین دو برد H100 پشتیبانی میکند و از تجمیع حافظه و مقیاسپذیری عملکرد (که به پشتیبانی از برنامه نیاز دارد) پشتیبانی میکند. MIG نسل دوم GPU را به بخشهای مجزای با اندازه مناسب تقسیم میکند تا QoS (کیفیت خدمات) را برای ۷ برابر بیشتر مستاجران ایمنسازی کند. گنجاندن NVIDIA AI Enterprise (که ویژه H100 PCIe است)، مجموعه نرمافزاری است که توسعه و استقرار گردشهای کاری AI شتابدهنده را بهینه میکند و از طریق این نوآوریهای معماری جدید H100 عملکرد را به حداکثر میرساند. این پیشرفتهای فناوری، H100 Tensor Core GPU را به قدرتمندترین GPU ساخته شده تا به امروز تبدیل میکند.

پیشرفتهترین تراشه جهان

ساخته شده با ۸۰ میلیارد ترانزیستور با استفاده از فرآیند پیشرفته TSMC 4N که به طور خاص برای نیازهای محاسبات شتابدهیشده NVIDIA طراحی شده است، H100 پیشرفتهترین تراشهای است که تاکنون ساخته شده است. این تراشه پیشرفتهای عمدهای را برای شتابدهی به AI (هوش مصنوعی)، HPC (محاسبات با عملکرد بالا)، پهنای باند حافظه، ارتباطات داخلی و ارتباطات در مقیاس مرکز داده به همراه دارد.

ویژگیهای پیشرفته اجرای آسنکرون (Asynchronous Transaction)

ویژگیهای جدید اجرای آسنکرون شامل یک واحد Tensor Memory Accelerator (TMA) است که میتواند بلوکهای بزرگی از دادهها را به صورت بسیار کارآمد بین حافظه جهانی و حافظه مشترک جابهجا کند. TMA همچنین از کپیهای آسنکرون بین Thread Blocks در یک Cluster پشتیبانی میکند. علاوه بر این، یک Asynchronous Transaction Barrier جدید برای انجام حرکتهای دادهای اتمیک و همگامسازی وجود دارد.

**معماری **NVIDIA Hopper

NVIDIA H100 Tensor Core GPU که توسط معماری GPU NVIDIA Hopper تغذیه میشود، جهش عظیمی را در عملکرد محاسبات شتابدهیشده برای پلتفرمهای مرکز داده NVIDIA ارائه میدهد. H100 بارهای کاری متنوعی را از بارهای کاری کوچک سازمانی، تا exascale HPC و مدلهای AI با تریلیون پارامتر شتابدهی میکند. این کارت با استفاده از فرآیند TSMC 4N که برای NVIDIA سفارشیسازی شده و دارای ۸۰ میلیارد ترانزیستور است، و با گنجاندن پیشرفتهای معماری متعدد، پیشرفتهترین تراشهای است که تاکنون ساخته شده است.

هستههای تنسور نسل چهارم

هستههای تنسور نسل چهارم جدید تا ۶ برابر سریعتر از A100 در ارتباطات تراشه به تراشه هستند، از جمله شتابدهی در سطح هر SM، افزایش تعداد SM و فرکانسهای بالاتر H100. در هر SM، هستههای تنسور ۲ برابر نرخهای MMA (Matrix Multiply-Accumulate) محاسباتی A100 SM را در دادههای معادل ارائه میدهند و ۴ برابر نرخ A100 را با استفاده از نوع داده جدید FP8، در مقایسه با گزینههای قبلی 16bit floating point فراهم میکنند. ویژگی Sparsity در H100 باعث بهرهبرداری از پراکندگی ساختاری دقیق در شبکههای یادگیری عمیق میشود و عملکرد عملیات هستههای تنسور استاندارد را دو برابر میکند.

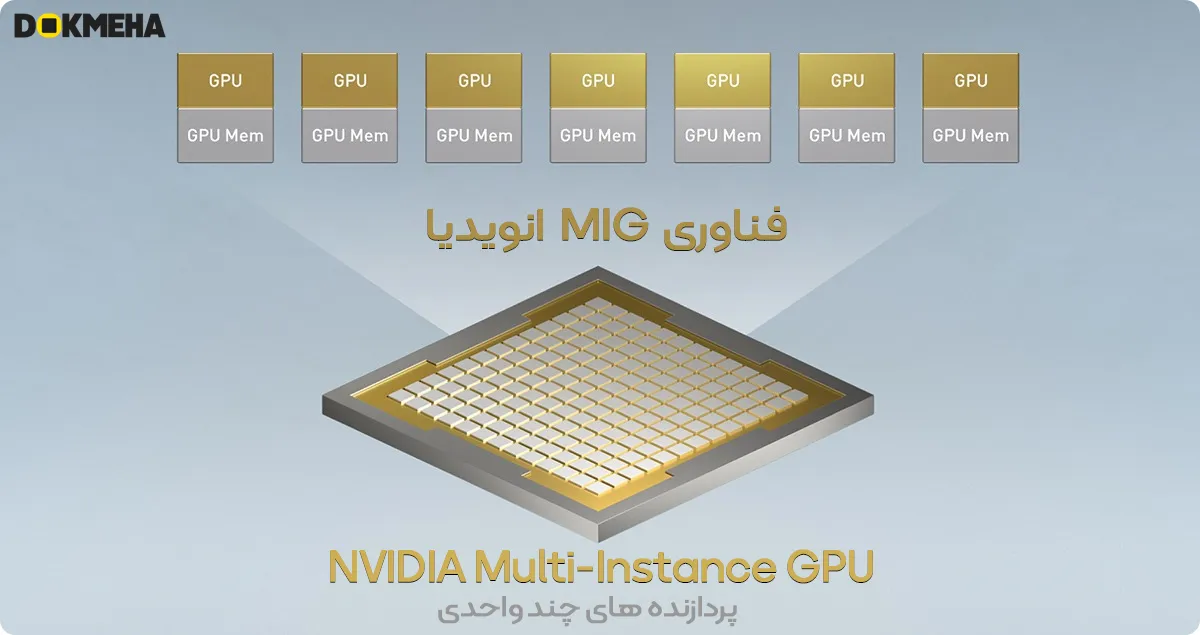

فناوری پردازنده گرافیکی چند واحدی (نسل دوم MIG)

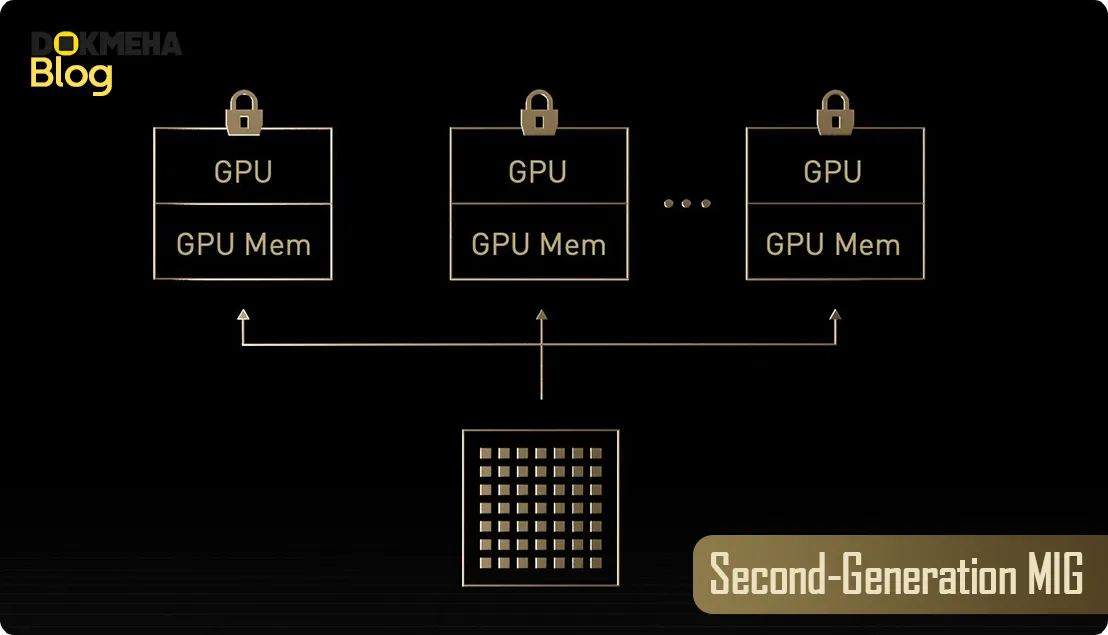

با معرفی MIG (Multi-Instance GPU) در Ampere، یک GPU میتواند به چندین Instance کوچکتر تقسیم شود که هر کدام دارای حافظه، کش و هستههای محاسباتی جداگانه هستند. معماری Hopper MIG را با پشتیبانی از پیکربندیهای چند مستأجره و چند کاربره در محیطهای مجازیسازیشده تا هفت GPU instance امنتر میکند و هر instance را با استفاده از محاسبات محرمانه در سطح سختافزار و hypervisor ایزوله میکند. دیکودرهای ویدیویی اختصاصی برای هر MIG instance، تحلیلهای ویدیویی هوشمند (IVA) با توان بالا و امنیت در زیرساختهای اشتراکی را ارائه میدهند. با MIG profiling همزمان در Hopper، مدیران میتوانند شتابدهی GPU را با اندازه مناسب نظارت کرده و تخصیص منابع را برای کاربران بهینه کنند. برای محققانی که بارهای کاری کوچکتری دارند، به جای اجاره یک CSP instance کامل، میتوانند از MIG استفاده کنند تا بخشی از GPU را بهطور امن ایزوله کنند و اطمینان حاصل کنند که دادههایشان در حالت سکون، در انتقال و در محاسبات ایمن است.

پشتیبانی از محاسبات محرمانه جدید (Built-In Confidential Computing)

راهحلهای محاسبات محرمانه امروزی مبتنی بر CPU هستند که برای بارهای کاری محاسباتی سنگین مانند AI و HPC محدود هستند. NVIDIA Confidential Computing یک ویژگی امنیتی داخلی(Built-In) در معماری NVIDIA Hopper است که NVIDIA H100 را به اولین شتابدهنده جهان با قابلیتهای محاسبات محرمانه داخلی تبدیل میکند. کاربران میتوانند محرمانگی و یکپارچگی دادهها و برنامههای خود را در حین استفاده محافظت کنند و در عین حال از شتابدهی بینظیر H100 بهرهمند شوند. این ویژگی یک محیط اجرای مورد اعتماد (TEE) مبتنی بر سختافزار ایجاد میکند که کل بار کاری اجرا شده بر روی یک GPU H100 واحد، چندین GPU H100 در یک گره، یا MIG instanceهای فردی را ایمن و ایزوله میکند. برنامههای شتابدهیشده توسط GPU میتوانند بدون تغییر در داخل TEE اجرا شوند و نیازی به تقسیمبندی ندارند. کاربران میتوانند قدرت نرمافزار NVIDIA برای AI و HPC را با امنیت ریشه اعتماد سختافزاری ارائه شده توسط NVIDIA Confidential Computing ترکیب کنند.

پراکندگی ساختاری (Structured Sparsity)

شبکههای AI بزرگ هستند و میلیونها تا میلیاردها پارامتر دارند. همه این پارامترها برای پیشبینی دقیق نیاز نیستند و برخی از آنها میتوانند به صفر تبدیل شوند تا مدلها “پراکنده” شوند بدون اینکه دقت مدل آسیب ببیند. هستههای تنسور در H100 میتوانند تا ۲ برابر عملکرد بالاتری برای مدلهای پراکنده ارائه دهند. در حالی که ویژگی پراکندگی بیشتر برای AI inference مفید است، میتواند عملکرد آموزش مدل را نیز بهبود بخشد.

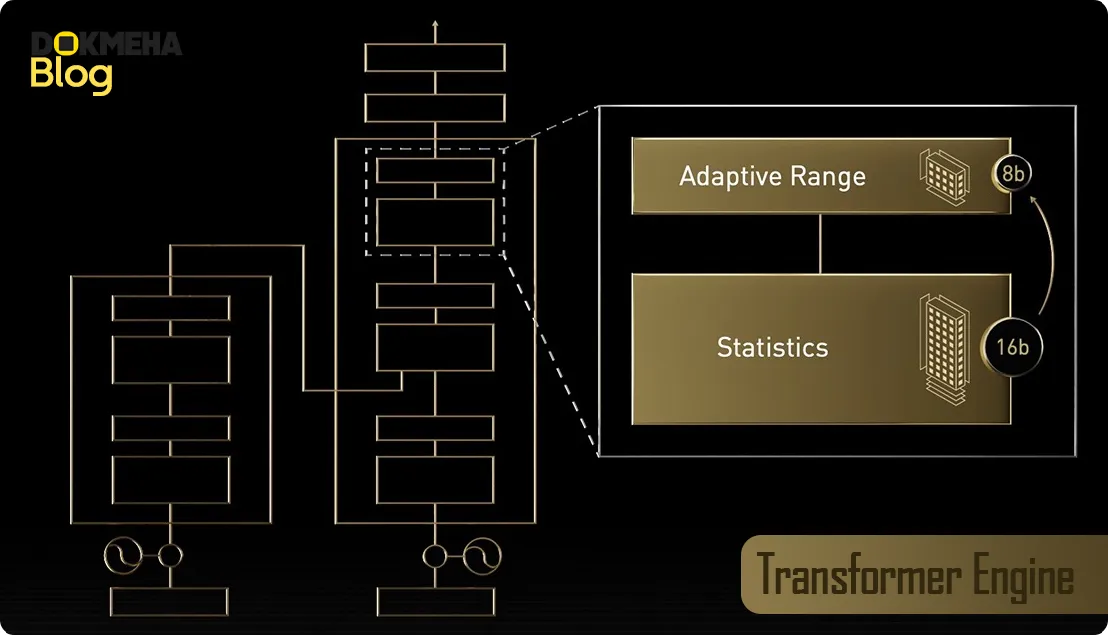

موتور Transformer Engine شتابدهنده AI، تا ۳۰ برابر عملکرد بالاتر

مدلهای Transformer ستون فقرات مدلهای زبانی (LLMs) هستند که امروزه بهطور گستردهای استفاده میشوند، از BERT تا GPT-3. این مدلها ابتدا برای استفاده در پردازش زبان طبیعی (NLP) توسعه یافتند و انعطافپذیری Transformer بهطور فزایندهای در بینایی کامپیوتری، کشف دارو و سایر زمینهها به کار گرفته میشود. اندازه آنها به طور تصاعدی افزایش مییابد و اکنون به تریلیونها پارامتر رسیده است و زمانهای آموزش آنها به ماهها کشیده شده که برای نیازهای کسبوکار غیرعملی است. Transformer Engine از نرمافزار و فناوری اختصاصی Hopper Tensor Core استفاده میکند که بهطور خاص برای شتابدهی به آموزش مدلهایی که از مهمترین بلوکهای ساخت مدل AI جهان، یعنی Transformer ساخته شدهاند، طراحی شده است. Hopper Tensor Cores قابلیت استفاده از فرمتهای دقت FP8 و FP16 را برای شتابدهی محاسبات AI برای Transformerها دارند.

**زیرسیستم حافظه HBM2e

H100 مقادیر زیادی محاسبات را به مراکز داده میآورد. برای استفاده کامل از آن عملکرد محاسباتی، NVIDIA H100 PCIe از حافظه HBM2e با پهنای باند حافظه ۲ ترابایت در ثانیه (TB/sec) که ۵۰ درصد افزایش نسبت به نسل قبلی دارد، استفاده میکند. علاوه بر ۸۰ گیگابایت حافظه HBM2e، H100 شامل ۵۰ مگابایت L2 cache است. ترکیب این حافظه سریعتر HBM و کش بزرگتر ظرفیت لازم برای شتابدهی به مدلهای AI محاسباتی فشرده را فراهم میآورد.

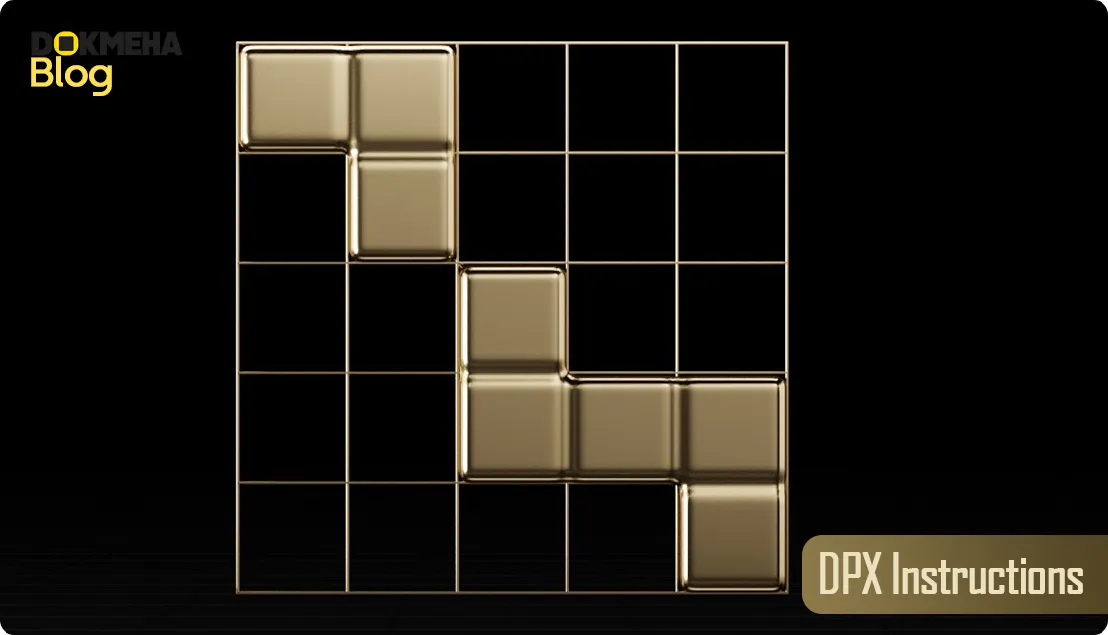

دستورات DPX جدید

برنامهنویسی پویا (Dynamic programming) یک تکنیک الگوریتمی برای حل مشکلات پیچیده بازگشتی است که با شکستن آنها به زیرمسئلههای سادهتر، زمان و پیچیدگی حل مسائل نمایی را کاهش میدهد. با ذخیره نتایج زیرمسئلهها بهگونهای که نیازی به محاسبه دوباره آنها نباشد، این روش باعث کاهش زمان و پیچیدگی حل مسائل میشود. برنامهنویسی پویا به طور معمول در دامنه وسیعی از موارد کاربرد استفاده میشود. به عنوان مثال، الگوریتم Floyd-Warshall یک الگوریتم بهینهسازی مسیر است که میتواند برای نقشهبرداری کوتاهترین مسیرها برای حمل و نقل و ناوگانهای تحویل استفاده شود. الگوریتم Smith-Waterman برای همراستاسازی دنبالههای DNA و برنامههای تا خوردن پروتئین استفاده میشود. Hopper دستورالعملهای DPX را معرفی میکند تا الگوریتمهای برنامهنویسی پویا را تا ۴۰ برابر (مقایسه دستورالعملهای DPU با CPU تا ۴۰ برابر) نسبت به CPUها و ۷ برابر نسبت به GPUهای معماری NVIDIA Ampere شتاب دهد. این باعث زمانهای بهطور چشمگیری سریعتر در تشخیص بیماری، بهینهسازی مسیرهای زمان واقعی و حتی تحلیلهای گراف میشود.

**ویژگی جدید Thread Block Cluster

این ویژگی کنترل برنامهنویسی موقعیت مکانی را در دانهبندی بزرگتر از یک Thread Block روی یک SM واحد امکانپذیر میسازد. این مدل برنامهنویسی CUDA را با افزودن یک سطح دیگر به سلسلهمراتب برنامهنویسی گسترش میدهد تا شامل Threads، Thread Blocks، Thread Block Clusters و Grids شود. Clusters به چندین Thread Block این امکان را میدهند که به صورت همزمان بر روی چندین SM اجرا شوند و دادهها را بهصورت همزمان همگامسازی کرده و با هم به اشتراک بگذارند.

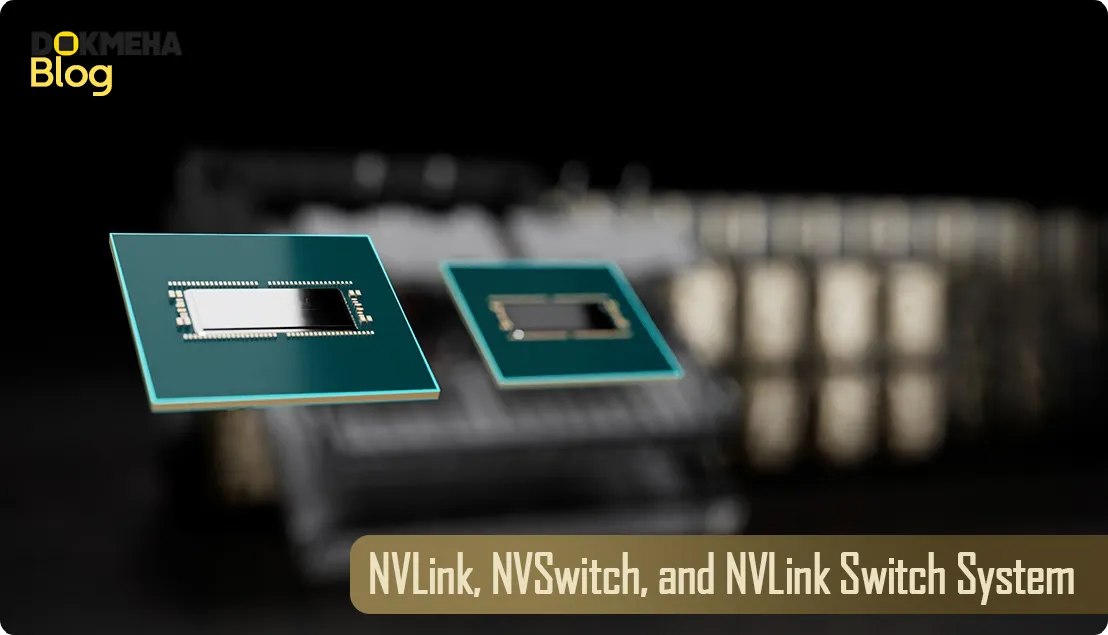

NVIDIA NVLink نسل چهارم

این فناوری افزایش ۳ برابری پهنای باند در عملیات all-reduce و افزایش ۵۰ درصدی پهنای باند عمومی نسبت به نسل قبلی NVLink را ارائه میدهد. پهنای باند کل ۹۰۰ گیگابایت در ثانیه برای multi-GPU I/O فراهم میکند که نزدیک به ۵ برابر پهنای باند PCIe Gen 5 است.

PCIe Gen5 برای CPUها و DPUهای پیشرفته

H100 اولین GPU از NVIDIA است که از PCIe Gen5 پشتیبانی میکند و بالاترین سرعتهای ممکن را با ۱۲۸ گیگابایت در ثانیه (دوطرفه) ارائه میدهد. این ارتباط سریع اتصال بهینهای را با CPUهای با عملکرد بالا، همچنین با NVIDIA ConnectX-7 SmartNICs و BlueField-3 DPUs فراهم میکند که شتابدهی شبکه Ethernet 400Gb/s یا NDR 400Gb/s InfiniBand را برای بارهای کاری امن HPC و AI فراهم میآورد.

آماده برای سازمانها: نرمافزار AI توسعه و استقرار را ساده میکند

پذیرش AI در سازمانها اکنون به روند اصلی تبدیل شده است و سازمانها به زیرساختهای آماده برای AI نیاز دارند که آنها را برای این دوران جدید آیندهنگر کند. GPUهای NVIDIA H100 Tensor Core برای سرورهای اصلی (PCIe) همراه با نرمافزار NVIDIA AI Enterprise ارائه میشوند و AI را با بالاترین عملکرد در آموزش، استنتاج و دادهکاوی برای تقریباً هر سازمانی قابل دسترس میسازند. NVIDIA AI Enterprise همراه با NVIDIA H100 ساخت یک پلتفرم آماده برای AI را ساده کرده، توسعه و استقرار AI را با پشتیبانی سطح سازمانی شتاب میدهد و عملکرد، امنیت و مقیاسپذیری لازم را برای به دست آوردن سریعتر بینشها و دستیابی به ارزش تجاری سریعتر فراهم میکند.

اطلاعات فنی کارت گرافیگ دیتاسنتر انویدیا NVIDIA H100 80GB HBM2e Data Center PCIe GPU Accelerator

| وزن | 3 کیلوگرم |

|---|---|

| کارایی و رده بندی | حرفه ای, دیتاسنتر, رندرینگ, علم داده (Data Science), کاربری صنعتی, محاسبه برنامه های کاربردی فشرده, هوش مصنوعی AI, ورک استیشن یا ایستگاه کاری, یادگیری عمیق DL, یادگیری ماشین ML |

| برند و سری | |

| مدل | NVIDIA H100 80GB HBM2e Data Center PCIe GPU Accelerator |

| وضعیت محصول | آکبند با کارتن خاکی, آکبند با کارتن رنگی, آکبند بالک بدون کارتن |

| کارت گرافیک / Graphics Card | Release Date: Mar 21st, 2023 |

| پردازنده گرافیکی / Graphics Processor | GPU Name : GH100 GH100 GPU Notes: Tensor Cores: 4th Gen |

| پیکربندی رندر / Render Config | Shading Units : 14592 |

| حافظه / Memory | Memory Size : 80 GB |

| سرعت اجرای پردازنده / Clock Speeds | Base Clock : 1095 MHz |

| صفحه نمایش / Display | No outputs |

| عملکرد نظری / Theoretical Performance | Pixel Rate: 42.12 GPixel/s FP64: 26 TFLOPS |

| ویژگی های گرافیک / Graphics Features | DirectX : N/A |

| برخورداری از APIهای محاسباتی | — |

| vGPU software support | — |

| vGPU profiles supported | — |

| پشتیبانی از تکنولوژیهای و ویژگی ها | NVIDIA H100 GPUs feature fourth-generation Tensor Cores and theTransformer Engine with FP8 precision, further extending NVIDIA’smarket-leading AI leadership with up to 9X faster training and anincredible 30X inference speedup on large language models. Forhigh-performance computing (HPC) applications, H100 triples thefloating-point operations per second (FLOPS) of FP64 and addsdynamic programming (DPX) instructions to deliver up to 7X higherperformance. With second-generation Multi-Instance GPU (MIG),built-in NVIDIA confidential computing, and NVIDIA NVLink SwitchSystem, H100 securely accelerates all workloads for every data centerfrom enterprise to exascale. |

| طراحی برد / Board Design | Slot Width : Dual-slot |

| ابعاد | Slot Width : Dual-slot |

| نوع رابط | |

| گارانتی | سرویس طلایی دکمه ها 10 روز مهلت تست و برگشت رایگان, گارانتی 18 ماهه معتبر داخلی, گارانتی 36 ماهه معتبر داخلی |

اطلاعات PDF:

تعداد نظرات 0

اولین نفری باشید که نظری را برای “کارت گرافیگ انویدیا NVIDIA H100 80GB PCIe” می نویسید.

لطفا برای نوشتن نظرات ابتدا وارد حساب کاربری شوید.

هنوز دیدگاه یا پرسشی ثبت نشده است.