سرور گرافیکی NVIDIA HGX SXM4 A100 8-GPU

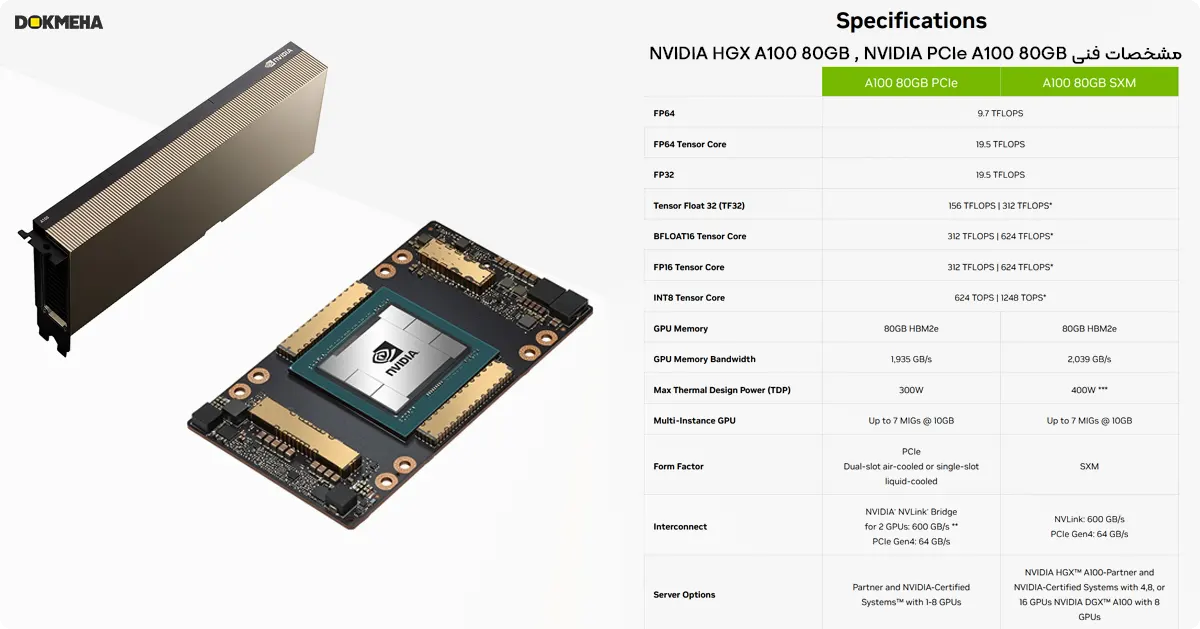

بزند و مدل: NVIDIA HGX SXM4 A100 8-GPU

کاربری: هوش مصنوعی AI – دیتاسنتر – یادگیری عمیق

- پردازنده گرافیک : NVIDIA HGX A100 8-GPU

- فرم فاکتور: 8x 80GB NVIDIA A100 SXM4

- چیپ ست و معماری : GA100 – Ampper

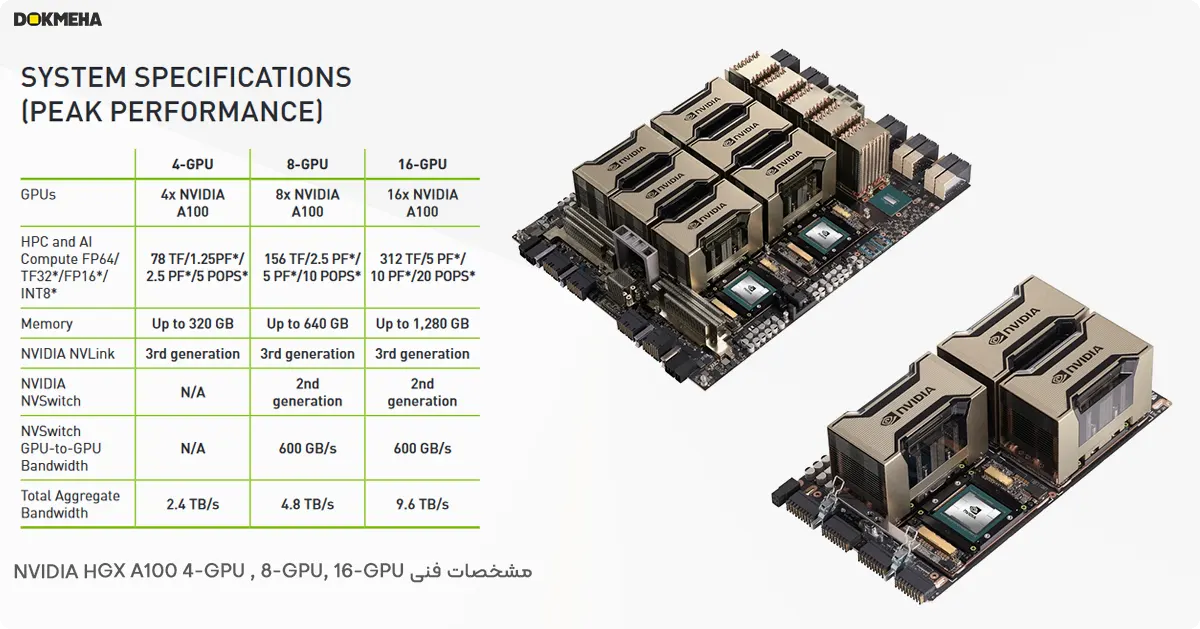

- فرمتهای محاسبه HPC و هوش مصنوعی(FP64/TF32*/FP16*/INT8*): 156TF/2.5PF*/5PF*/10POPS*

- ظرفیت و نوع حافظه گرافیک : 640GB HBM2e with (ECC)

- پهنای باند حافظه : 4.8TB/s

- رابط حافظه : 5120bit

- رابط اتصال: PCIe 4.0 x16

- مصرف برق : 400W

- پشتیبانی از NVSwitch 2rd Gen / NVLink 3rd Gen

تحویل کالا: ۷تا35 روز کاری.

وضعیت محصول: آکبند(کارتن و متعلقات).

گارانتی: یکسال گارانتی شرکت NVIDIA (5سال خدمات پسازفروش)

کابل و متعلقات اضافی: قابل سفارش

ناموجود

سرور گرافیکی یا ابر رایانه هوش مصنوعی NVIDIA HGX A100 SXM4 8xGPU

ابر رایانه یا پردازنده گرافیکی NVIDIA HGX A100 ، یک پلتفرم کلیدی مبتنی بر سرور GPU به شمار میرود. این پلتفرم پیشرفته با امنیت بالا، عملکردی با تاخیر کم ارائه می دهد و مجموعه کاملی از قابلیت ها را از شبکه تا محاسبات در مقیاس مرکز داده،که برای تسریع امور مرتبط با هوش مصنوعی (AI) و محاسبات با عملکرد بالا (HPC) طراحی شده است.

سرور گرافیکی NVIDIA HGX A100 SXM4 80GB محصول شرکت انویدیا است که در تاریخ ۱۶ نوامبر ۲۰۲۰ عرضه شد. این پردازنده گرافیک بر پایه معماری ۷ نانومتری ساخته شده و از پردازنده گرافیکی GA100 استفاده می کند، اما از DirectX پشتیبانی نمی کند. به همین دلیل، ممکن است برخی از جدیدترین بازی ها را اجرا نکند. پردازنده گرافیکی GA100 یک تراشه بزرگ با مساحت ۸۲۶ میلی متر مربع و ۵۴.۲ میلیارد ترانزیستور است. این پردازنده دارای ۶۹۱۲ واحد سایه زن، ۴۳۲ واحد نگاشت بافت و ۱۶۰ واحد خروجی رندر (ROP) می باشد. همچنین ۴۳۲ هسته تنسور در آن تعبیه شده که به بهبود سرعت اجرای برنامه های یادگیری ماشین کمک می کند.

حافظه این پردازنده گرافیک از نوع ۸۰ گیگابایت HBM2e است که با رابط ۵۱۲۰ بیتی به پردازنده متصل شده است. فرکانس کاری پردازنده گرافیکی ۱۲۷۵ مگاهرتز است که تا ۱۴۱۰ مگاهرتز قابل افزایش است و حافظه نیز با فرکانس ۱۵۹۳ مگاهرتز کار می کند. پردازنده گرافیک A100 SXM4 80 گیگابایت از نوع ماژول SXM4 است و به همین دلیل به کانکتور برق جداگانه نیاز دارد. توان مصرفی این کارت ۴۰۰ وات است. همچنین خروجی تصویر ندارد زیرا برای اتصال مستقیم مانیتور طراحی نشده است. در نهایت، این کارت از طریق رابط PCI-Express 4.0 x16 به سایر اجزای سیستم متصل می شود.

انویدیا: تسریع بخشیدن به کار نوابغ عصر ما

هدف انویدیا سرعت بخشیدن به کار داوینچیها و انیشتینهای زمان ماست. دانشمندان، پژوهشگران و مهندسان با استفاده از هوش مصنوعی (AI) و رایانش پر بازده (HPC) بر حل برخی از مهمترین چالشهای علمی، صنعتی و کلاندادهی جهان تمرکز کردهاند.

کارت گرافیک قدرتمند NVIDIA HGX A100 با پردازندههای گرافیکی A100 Tensor Core، جهش عظیمی را در پلتفرم شتابدهندهی مراکز دادهی ما ایجاد میکند. این کارت، شتابی بیسابقه در هر مقیاسی ارائه میدهد و به نوآوران این امکان را میدهد تا کارهای مهم زندگی خود را در طول عمرشان به انجام برسانند.

در این مطلب، دو پلتفرم HGX A100 را برای پیشبرد هوش مصنوعی و رایانش پر بازده معرفی میکنم:

- HGX A100 8-GPU که با NVSwitch متصل میشود.

- HGX A100 4-GPU که با NVLink متصل میشود.

در ادامه، به موارد استفاده، مزایای کاربردی و توصیههایی در مورد بهترین روش برای ادغام HGX A100 در سرورهای نسل بعدی میپردازم. این امر به شما کمک میکند تا دیدگاهی جامعتر در سطح سیستم داشته باشید و از آخرین فناوریهای محاسباتی به طور مؤثرتر استفاده کنید.

HGX A100 با ۸ پردازنده گرافیکی و NVSwitch: سریعترین مسیر برای رسیدن به راهحل

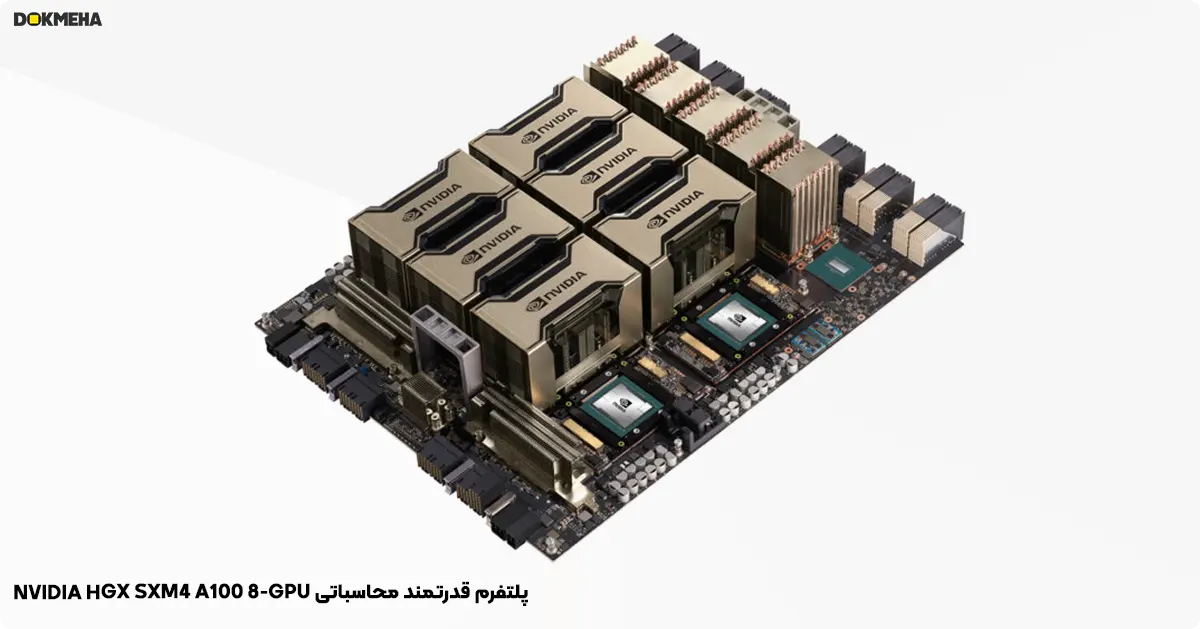

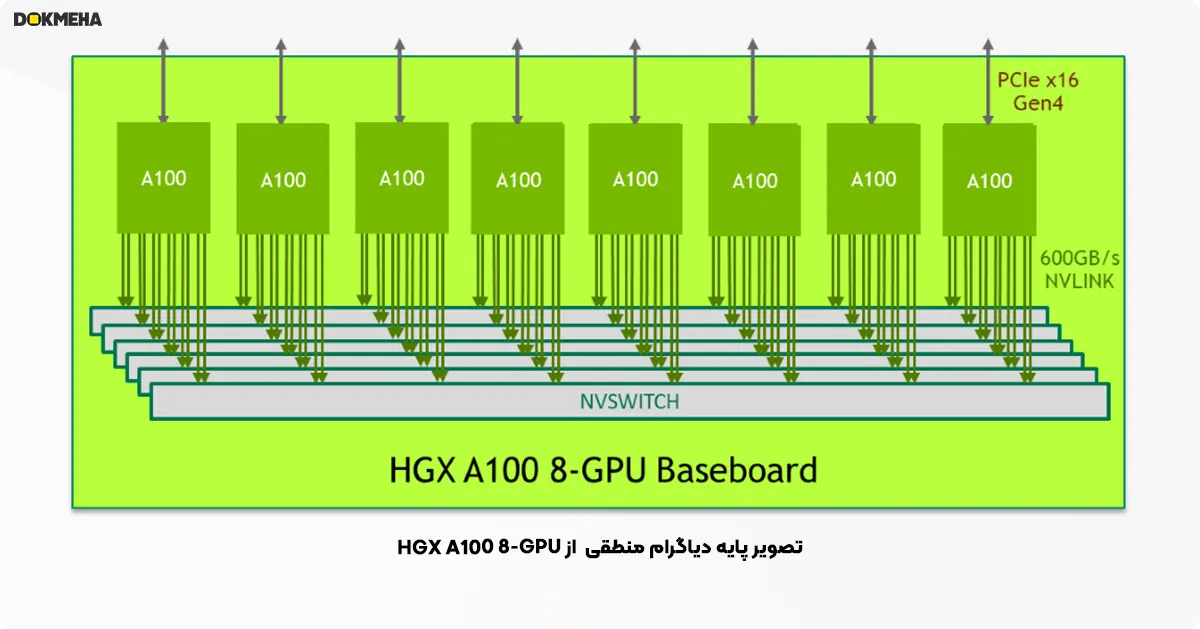

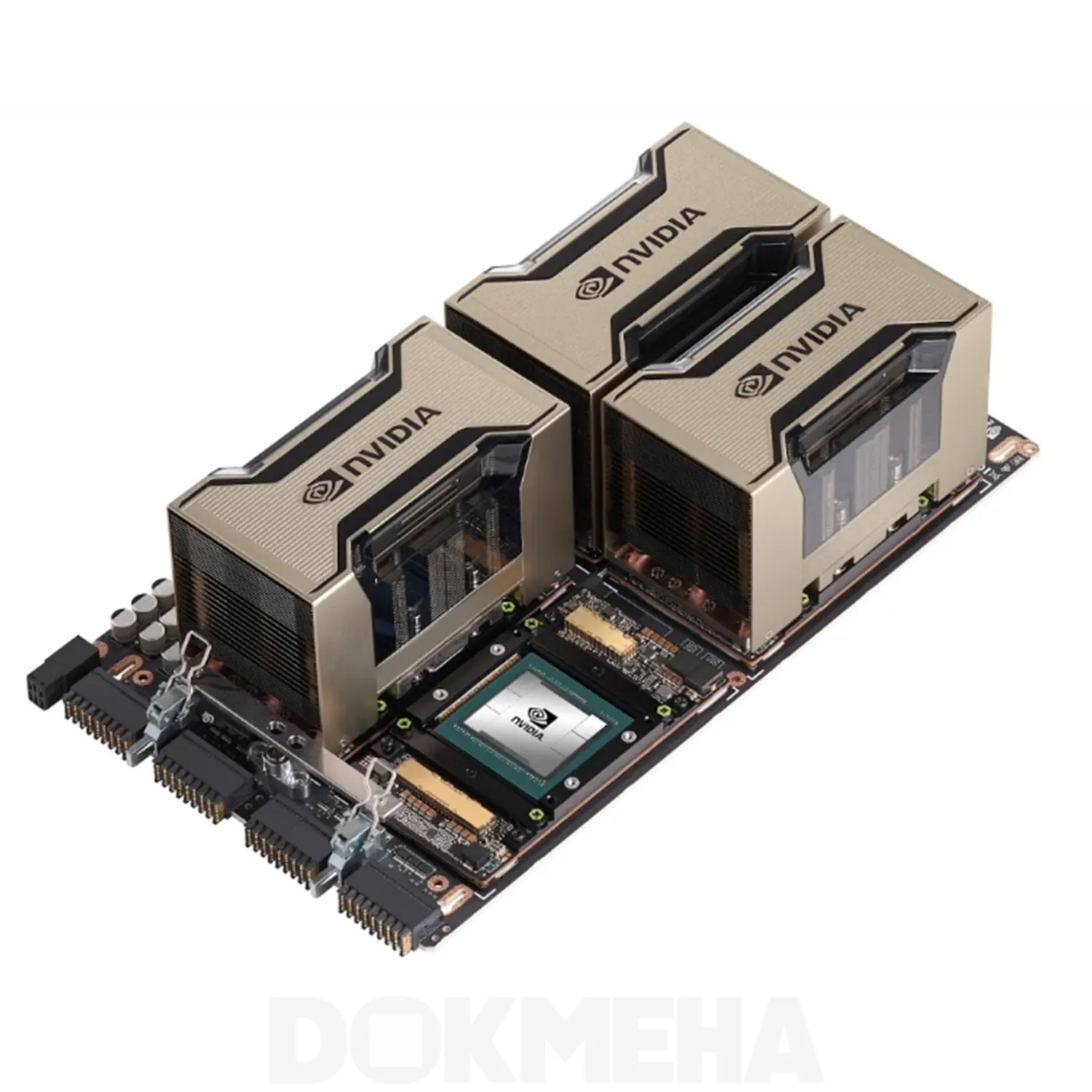

برد اصلی HGX A100 با ۸ پردازندهی گرافیکی، بلوک کلیدی پلتفرم سرور HGX A100 است. تصویر زیر این برد اصلی را نشان میدهد که میزبان هشت پردازندهی گرافیکی A100 Tensor Core و شش گرهی NVSwitch است. هر پردازندهی گرافیکی A100 دارای ۱۲ پورت NVLink است و هر گرهی NVSwitch یک سوئیچ NVLink کاملاً غیرمسدودکننده است که به هر هشت پردازندهی گرافیکی A100 متصل میشود.

این توپولوژی مش کاملاً متصل به هر پردازندهی گرافیکی A100 اجازه میدهد تا با هر پردازندهی گرافیکی A100 دیگر با سرعت دو طرفهی کامل NVLink یعنی ۶۰۰ گیگابایت بر ثانیه ارتباط برقرار کند که ۱۰ برابر پهنای باند سریعترین گذرگاه PCIe نسل ۴ درگاه ۱۶ است. همچنین میتوان دو برد اصلی را با استفاده از NVSwitch به NVLink به صورت پشت سر هم متصل کرد تا امکان اتصال کامل ۱۶ پردازندهی گرافیکی A100 فراهم شود.

نکات کلیدی:

- HGX A100 با ۸ پردازندهی گرافیکی، هستهی اصلی سرور HGX A100 است.

- هر پردازندهی گرافیکی A100 دارای ۱۲ پورت NVLink برای اتصال با سایر پردازندهها است.

- سوئیچهای NVSwitch ارتباط کاملاً غیرمسدودکننده بین تمام پردازندههای گرافیکی را برقرار میسازند.

- سرعت اتصال NVLink، ۱۰ برابر سریعتر از PCIe نسل ۴ است (۶۰۰ گیگابایت بر ثانیه در مقابل ۶۰ گیگابایت بر ثانیه).

- میتوان با اتصال دو برد اصلی با استفاده از NVSwitch، سرورهایی با ۱۶ پردازندهی گرافیکی A100 ایجاد کرد.

این پیکربندی به سریعترین زمان رسیدن به راهحل برای کارهای هوش مصنوعی و رایانش پر بازده کمک میکند.

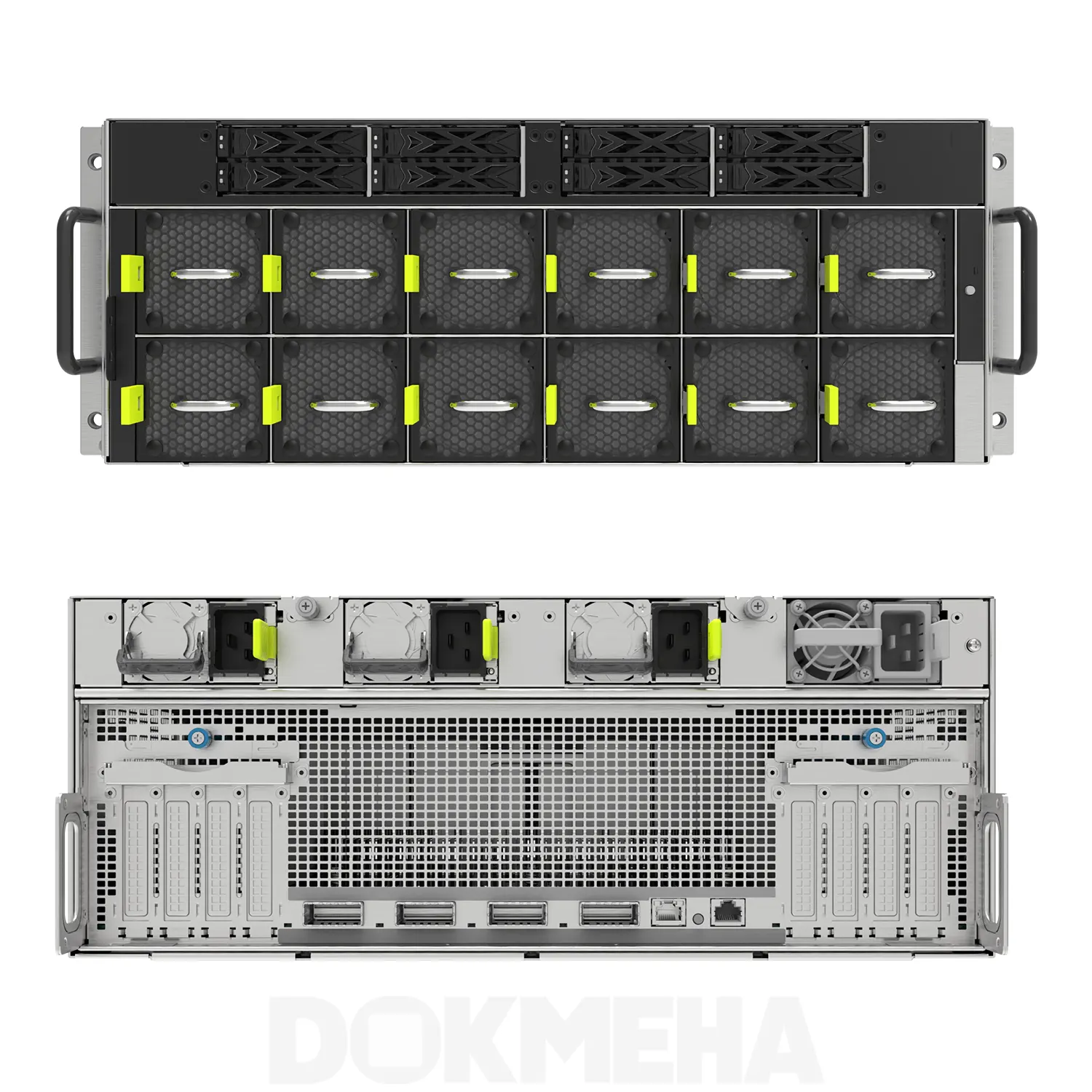

ایجاد پلتفرم سرور HGX A100 با ۸ پردازنده گرافیکی

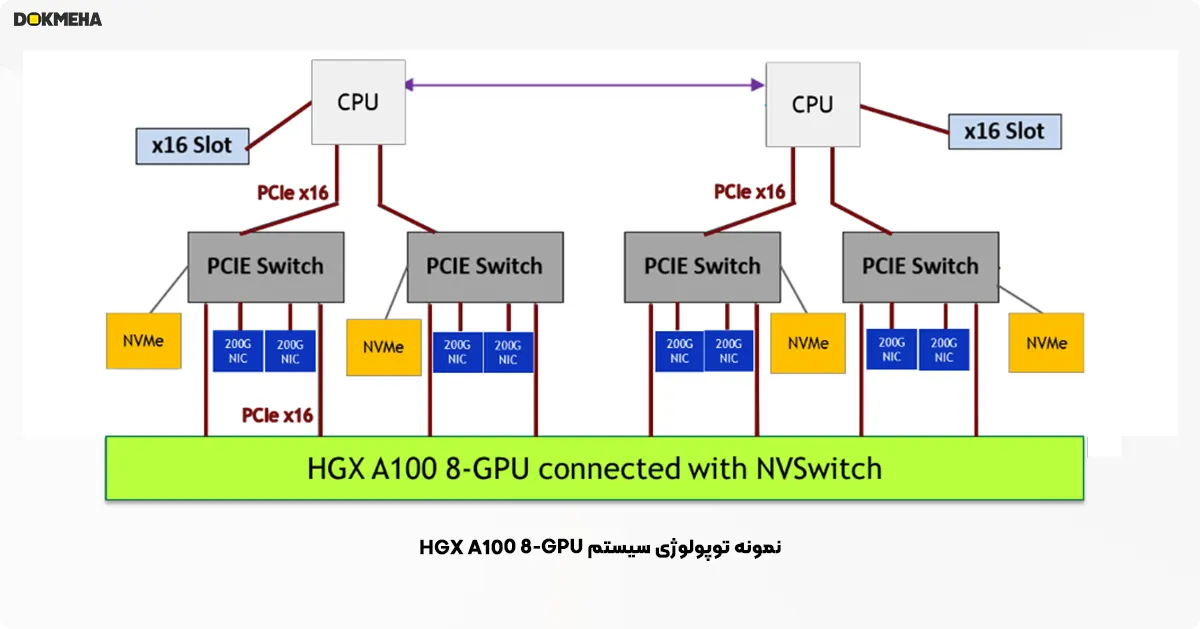

با داشتن برد اصلی حاوی پردازندههای گرافیکی به عنوان قطعهی کلیدی، شرکای سیستم سرور انویدیا، باقیماندهی پلتفرم سرور را با نیازهای خاص کسبوکار، از جمله زیرسیستم پردازنده مرکزی، شبکه، ذخیرهسازی، برق، شکل ظاهری و مدیریت گره، تطبیق میدهند. برای دستیابی به بالاترین عملکرد، توصیههای زیر در طراحی سیستم پیشنهاد میشود:

- استفاده از دو عدد پردازنده مرکزی قدرتمند: برای همگام شدن با هشت پردازندهی گرافیکی A100، از دو عدد از قدرتمندترین پردازندههای مرکزی سرور استفاده کنید.

- استفاده از تعداد کافی لینک PCIe: حداقل از چهار لینک PCIe x16 بین دو پردازندهی مرکزی و هشت پردازندهی گرافیکی A100 استفاده کنید تا پهنای باند کافی برای ارسال دستورات و دادهها از پردازندههای مرکزی به پردازندههای گرافیکی A100 وجود داشته باشد.

- شبکه با عملکرد بالا: برای دستیابی به بهترین عملکرد در آموزش هوش مصنوعی در مقیاس (اجرای یک کار آموزش بر روی گرههای بسیار زیاد به صورت همزمان)، عملکرد شبکه بین گرهها حیاتی است. نسبت تعداد کارتهای شبکه (NIC) به پردازندههای گرافیکی A100 را تا ۱ به ۱ در نظر بگیرید. کارت شبکه Mellanox ConnectX-6 میزان ۲۰۰ گیگابیت بر ثانیه بهترین گزینه است.

- اتصال کارت شبکه و حافظهی NVMe به سوئیچ PCIe و قرار دادن آنها نزدیک به پردازندههای گرافیکی A100: از توپولوژی درختی PCIe با عمق کم و متوازن استفاده کنید. سوئیچ PCIe سریعترین انتقال همتا به همتا را از کارت شبکه و حافظهی NVMe به داخل و خارج از پردازندههای گرافیکی A100 فراهم میکند.

- بکارگیری GPUDirect Storage: این فناوری تأخیر خواندن/نوشتن را کاهش میدهد، سربار پردازنده مرکزی را کم میکند و عملکرد بالاتری را امکان پذیر می کند.

با رعایت این نکات، سرورهای HGX A100 با ۸ پردازندهی گرافیکی برای اجرای سریعتر کارهای هوش مصنوعی و رایانش پر بازده بهینهسازی میشوند.

مزایای NVSwitch در پلتفرم HGX A100 با ۸ پردازنده گرافیکی

برد اصلی HGX A100 با ۸ پردازندهی گرافیکی، از جدیدترین نسل سوئیچهای NVSwitch بهره میبرد. NVSwitch علاوه بر اینکه امکان برقراری سریعترین ارتباط همتا به همتای A100 با سرعت ۶۰۰ گیگابایت بر ثانیه را فراهم میکند، به موارد زیر نیز کمک میکند:

- برنامهنویسی آسانتر: نیازی نیست نگران توپولوژی خاص بین پردازندههای گرافیکی A100 باشید. هر پردازندهی گرافیکی A100 میتواند با هر پردازندهی گرافیکی دیگر با سرعت کامل ۶۰۰ گیگابایت بر ثانیه NVLink ارتباط برقرار کند. شما میتوانید زمان بیشتری را صرف حل مسائل علمی کرده و وقت کمتری را صرف نگرانی در مورد پیادهسازیهای خاص سیستم نمایید.

- مدلهای هوش مصنوعی بسیار بزرگتر: مدلهای هوش مصنوعی بزرگتر اغلب به بهبود دقت پیشبینی کمک میکنند. موازیسازی مدل، یک مدل بزرگ را تقسیم کرده و آن را در حافظه پردازندههای گرافیکی A100 مختلف توزیع میکند. NVSwitch تضمین میکند که ارتباط شدید درون مدل به گلوگاه تبدیل نشود. در نتیجه، موازیسازی مدل در حال حاضر امکانپذیرتر شده است.

- جداسازی منعطف چند کاربره: هنگامی که چندین کاربر یک سیستم HGX A100 با ۸ پردازندهی گرافیکی را به اشتراک میگذارند (به گونهای که هر کاربر مالک یک یا چند پردازندهی گرافیکی A100 باشد)، سوئیچ NVSwitch میتواند با غیرفعال کردن پورتهای NVLink، کاربران را ایزوله کند و در عین حال، سرعت کامل ارتباط همتا به همتای NVLink را بین پردازندههای گرافیکی A100 که متعلق به یک کاربر خاص است، حفظ نماید.

به طور کلی، NVSwitch پیچیدگی برنامهنویسی را کاهش میدهد، از مدلهای هوش مصنوعی بزرگتر پشتیبانی میکند و انعطافپذیری بیشتری را برای استقرارهای چند کاربره فراهم میکند. این عوامل باعث میشوند تا HGX A100 با ۸ پردازندهی گرافیکی راهحلی ایدهآل برای طیف گستردهای از کارهای هوش مصنوعی و رایانش بازدهی بیشتری داشته باشد.

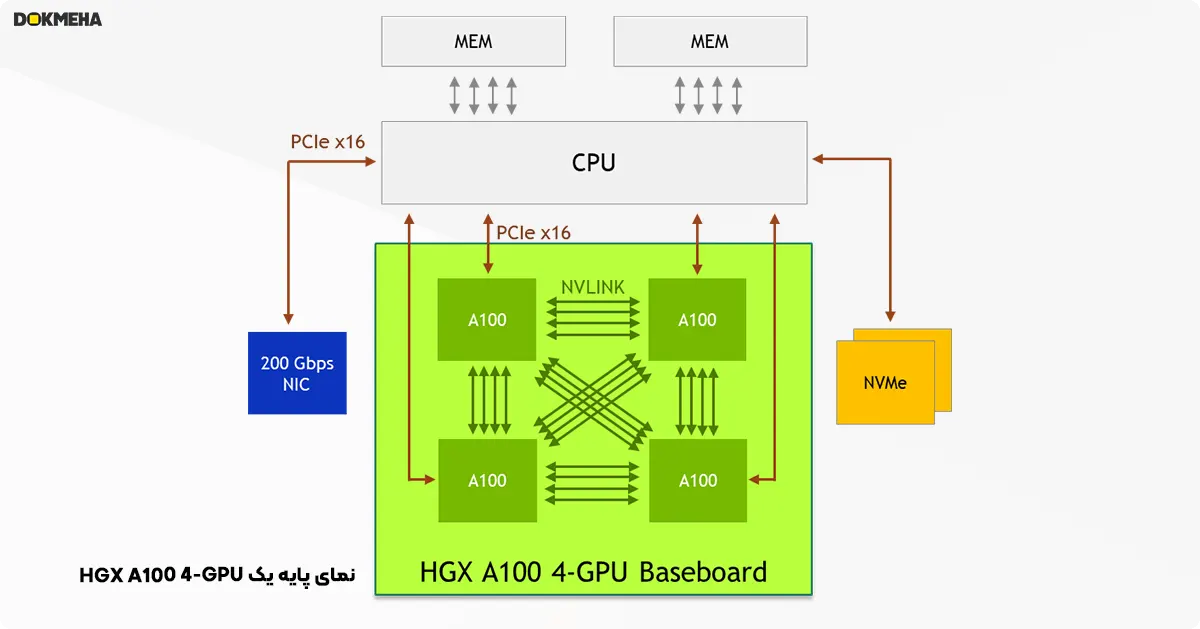

HGX A100 با ۴ پردازنده گرافیکی و NVLink: مناسب برای تسریع امور با کاربردهای عمومی

در حالی که پلتفرم HGX A100 با ۸ پردازنده گرافیکی و NVSwitch سریعترین عملکرد را ارائه میدهد، سناریوهای کاربردیای وجود دارند که در آنها یک گرهی سرور HGX A100 با ۴ پردازندهی گرافیکی ایدهآل است. در اینجا چند نمونه ذکر شده است:

- نیاز به ظرفیت پردازنده مرکزی بیشتر: برخی از برنامههای علمی، به خصوص آنهایی که با محاسبات سنگین سر و کار دارند، از ظرفیت پردازنده مرکزی بیشتری نسبت به پردازندههای گرافیکی بهره میبرند. نسبت چهار پردازندهی گرافیکی به دو پردازنده مرکزی، تعادل مناسبتری را برای چنین سناریوهایی برقرار میکند.

- محدودیت توان در مرکز داده: در برخی مراکز داده، به دلیل محدودیتهای زیرساختی، توان قفسه (رک) برای تأمین انرژی سرورها محدود است. در چنین مواقعی، استفاده از پلتفرمی با تعداد کمتر پردازندهی گرافیکی و در نتیجه مصرف پایینتر انرژی، ترجیح داده میشود.

- تخصیص منابع به صورت گرهای: برخی از مدیران سایتهای محاسباتی ترجیح میدهند منابع را به صورت واحدهای گرهای (با حداقل یک گره) به کاربران اختصاص دهند. گرهی HGX A100 با ۴ پردازندهی گرافیکی، امکان تخصیص با جزئیات (گرانولاریتی) بیشتر را فراهم کرده و از این طریق به پشتیبانی از کاربران بیشتر کمک میکند.

به طور خلاصه، HGX A100 با ۴ پردازندهی گرافیکی، انتخابی ایدهآل برای سناریوهایی است که در آنها:

- نیاز به تعادل مناسب بین قدرت پردازنده مرکزی و پردازندهی گرافیکی وجود دارد.

- محدودیت توان در مرکز داده یک عامل کلیدی است.

- تخصیص منابع به صورت گرهای برای مدیریت کاربران ترجیح داده میشود.

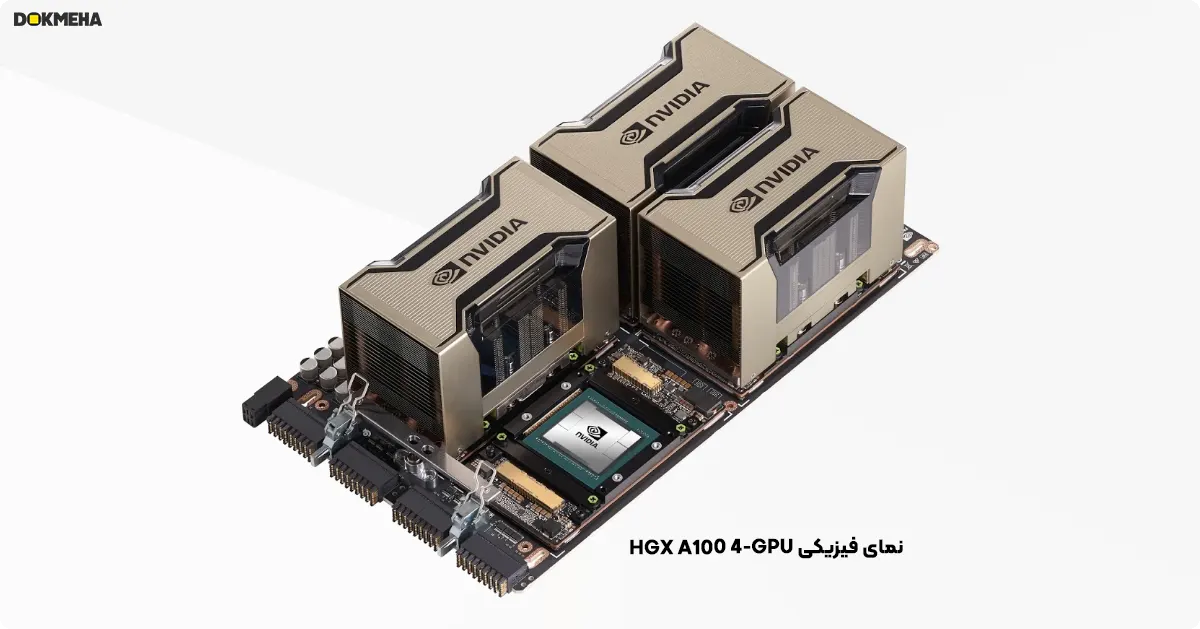

چهار پردازنده گرافیکی A100 در پایه پردازنده گرافیکی مستقیماً به NVLink متصل هستند و امکان اتصال کامل را فراهم می کنند. هر پردازنده گرافیکی A100 می تواند با استفاده از پورت های پرسرعت NVLink به حافظه هر پردازنده گرافیکی دیگر A100 دسترسی داشته باشد. پهنای باند همتای A100 به A100 به اندازه ۲۰۰ گیگابایت بر ثانیه دو جهته است که بیش از ۳ برابر سریعتر از سریعترین گذرگاه PCIe Gen4 x16 است.

ایجاد پلتفرم سرور HGX A100 با ۴ پردازندهی گرافیکی

برای دستیابی به حداکثر بازدهی در فرآیند شتابدهی، رعایت نکات زیر در طراحی سیستم پیشنهاد میشود:

- استفاده از یک پردازنده مرکزی قدرتمند: در صورتی که نیازمند ظرفیت پردازندهی مرکزی اضافی نباشید، از یک پردازندهی مرکزی تک با تعداد هسته بالا استفاده کنید. این کار باعث کاهش هزینه کل مواد (BOM) و مصرف برق سیستم شده و زمانبندی را سادهتر میکند.

- اتصال مستقیم CPU به A100 GPU: سوئیچ PCIe را کنار بگذارید و پردازندهی مرکزی را مستقیماً به پردازندههای گرافیکی A100 متصل کنید تا در هزینه کل مواد (BOM) و مصرف برق سیستم صرفهجویی شود.

- تجهیز گره با NIC و NVMe پرسرعت: برای پوشش دادن گسترهی وسیعی از موارد استفاده، گره را به یک یا دو کارت شبکه (NIC) 200 گیگابیت بر ثانیه و حافظهی NVMe مجهز کنید. کارت شبکه Mellanox ConnectX-6 به میزان ۲۰۰ گیگابیت بر ثانیه بهترین گزینه است.

- بکارگیری GPUDirect Storage: این فناوری تأخیر خواندن/نوشتن را کاهش میدهد، سربار پردازنده مرکزی را کم میکند و عملکرد بالاتری را امکان پذیر می کند.

با رعایت این نکات، سرورهای HGX A100 با ۴ پردازندهی گرافیکی برای اجرای سریعتر کارهای هوش مصنوعی و رایانش پر بازده بهینهسازی میشوند. تصویر زیر نمونه ای از معماری سیستم که در آن HGX A100 4-GPU یک طراحی ساده و کارآمد را امکان پذیر می کند و BOM سیستم و قدرت کمتر سیستم را به حداقل می رساند.

کاربردهای حرفه ای انویدیا HGX A100

۱. قدرتمندترین پلتفرم جامع هوش مصنوعی (AI) و محاسبات با عملکرد بالا (HPC) برای مراکز داده

NVIDIA HGX A100 ترکیبی از جدیدترین پردازندههای گرافیکی NVIDIA A100 Tensor Core، اتصال پرسرعت NVLink و NVSwitch، و نرمافزارهای کاملاً بهینه شده برای هوش مصنوعی و محاسبات سطح بالا (HPC) است. این پلتفرم، جهشی عظیم در تسریع مراکز دادهی ما ایجاد میکند و به محققان، دانشمندان و مهندسان این امکان را میدهد تا روی حل مهمترین چالشهای علمی، صنعتی و کلاندادهی جهان با سرعتی بیسابقه کار کنند.

NVIDIA HGX: سکویی ایدهآل برای همگرایی شبیهسازی، تحلیل داده و هوش مصنوعی

مجموعه دادههای عظیم، مدلهای بسیار بزرگ و شبیهسازیهای پیچیده نیازمند پردازندههای گرافیکی (GPU) متعدد با اتصالات فوقالعاده سریع هستند. پلتفرم NVIDIA HGX با گردهم آوردن تمام توان پردازندههای گرافیکی NVIDIA، فناوری NVLink، شبکهی NVIDIA Mellanox InfiniBand و کلکسیون نرمافزاری کاملاً بهینهسازیشدهی هوش مصنوعی و رایانش پر بازده (HPC) NVIDIA از NGC، بالاترین عملکرد را برای اجرای برنامهها به ارمغان میآورد. انعطافپذیری و عملکرد بینظیر NVIDIA HGX به محققان و دانشمندان اجازه میدهد تا با ترکیب شبیهسازی، تحلیل داده و هوش مصنوعی، پیشرفتهای علمی را تسریع بخشند.

با بهرهگیری از نسل جدید پردازندههای گرافیکی A100 با ظرفیت ۸۰ گیگابایت حافظه، یک سیستم HGX A100 به تنهایی میتواند تا ۱.۳ ترابایت حافظهی پردازندهی گرافیکی و پهنای باند حافظهی خیرهکنندهی ۲ ترابایت بر ثانیه را ارائه دهد. این قابلیت، شتابی بیسابقه را برای پردازشهای نوظهور که نیازمند مدلهای بسیار بزرگ و مجموعه دادههای عظیم هستند، فراهم میکند.

نسل سوم NVLink: خلق یک ابر GPU واحد

اجرای برنامهها بر روی چندین پردازندهی گرافیکی نیازمند انتقال اطلاعات با سرعتی بسیار بالا است. نسل سوم فناوری NVLink شرکت انویدیا که در پردازندههای گرافیکی A100 Tensor Core تعبیه شده است، پهنای باند مستقیم بین پردازندههای گرافیکی را به ۶۰۰ گیگابایت بر ثانیه افزایش میدهد که تقریباً ۱۰ برابر سریعتر از نسل چهارم PCIe است. نسل سوم NVLink در سرورهای HGX A100 با ۴ و ۸ پردازندهی گرافیکی از شرکتهای پیشرو در زمینهی تولید رایانه در دسترس است.

نسل دوم NVSwitch: پیشران محاسبات با پهنای باند کامل

NVSwitch NVIDIA که با فناوری NVLink پشتیبانی میشود، یک شبکهی واحد ایجاد میکند که به کل گره (مجموعهی سختافزاری) اجازهی عملکرد به عنوان یک پردازندهی گرافیکی غولآسا را میدهد. محققان میتوانند بدون محدودیت در توان محاسباتی، مدلهایی در مقیاسهای بیسابقه اجرا کنند و پیچیدهترین مسائل رایانش پر بازده را حل نمایند.

۲. یادگیری عمیق

-

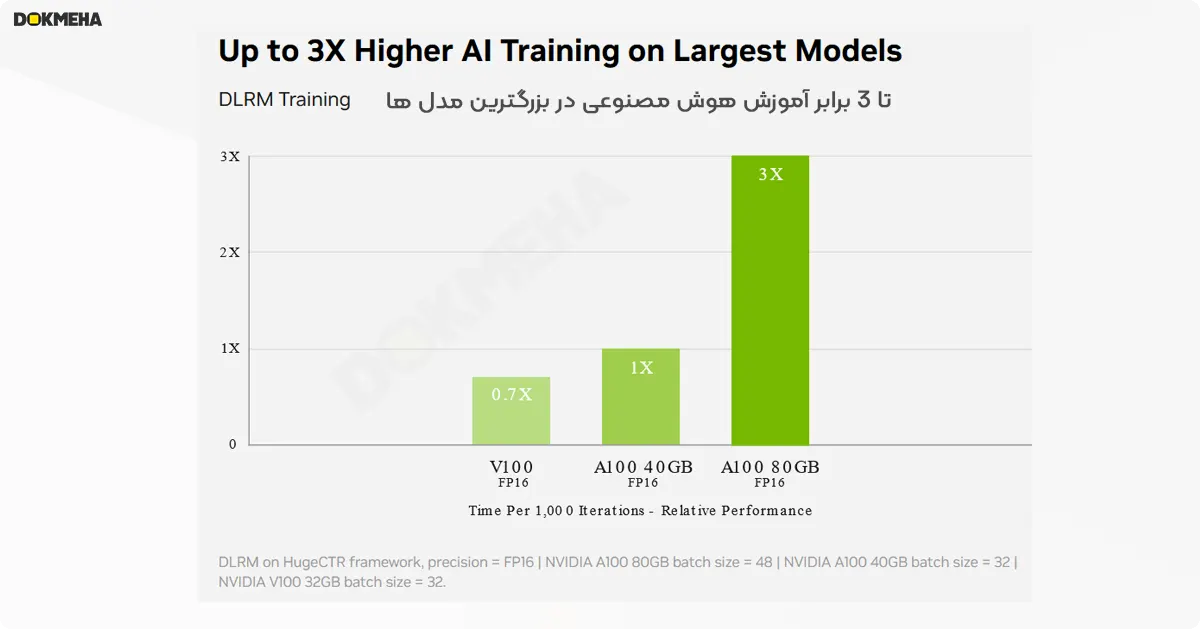

آموزش یادگیری عمیق

مدلهای هوش مصنوعی با روی آوردن به چالشهای پیچیدهتر مانند هوش مصنوعی مکالمهمحور، روز به روز پیچیدهتر میشوند. آموزش این مدلها نیازمند قدرت محاسباتی بسیار زیاد و قابلیت ارتقاء (مقیاسپذیری) است.

هستههای تنسور NVIDIA A100 با تنسور فلوت (TF32) تا ۲۰ برابر عملکرد بهتر نسبت به نسل پیشین (NVIDIA Volta) ارائه میدهند، بدون اینکه نیاز به تغییر کد باشد. همچنین با دقت مختلط خودکار و FP16، این عملکرد تا ۲ برابر دیگر نیز افزایش مییابد. با ترکیب این فناوریها با NVIDIA NVLink، NVIDIA NVSwitch، نسل چهارم رابط درگاه مشترک (PCIe Gen4)، NVIDIA InfiniBand و کیت توسعه نرمافزاری NVIDIA Magnum IO امکان اتصال هزاران پردازنده گرافیکی A100 به یکدیگر فراهم میشود.

با استفاده از ۲۰۴۸ پردازنده گرافیکی A100، یک حجم کاری آموزشی مانند مدل BERT را میتوان تنها در کمتر از یک دقیقه در مقیاس بزرگ حل کرد که این سرعت، رکورد جهانی زمان رسیدن به راهحل به شمار میرود.

برای مدلهای بسیار بزرگ با جداول دادهای حجیم مانند مدلهای توصیهگر یادگیری عمیق (DLRM)، حافظهی یکپارچهی هر گرهی A100 نسخهی ۸۰ گیگابایتی تا ۱.۳ ترابایت میرسد و توان عملیاتی آن تا ۳ برابر سریعتر از نسخهی ۴۰ گیگابایتی A100 است.

نفوذ و پیشتازی شرکت NVIDIA در MLPerf، با ثبت چندین رکورد عملکردی در این بنچمارک صنعتی برای آموزش هوش مصنوعی.

-

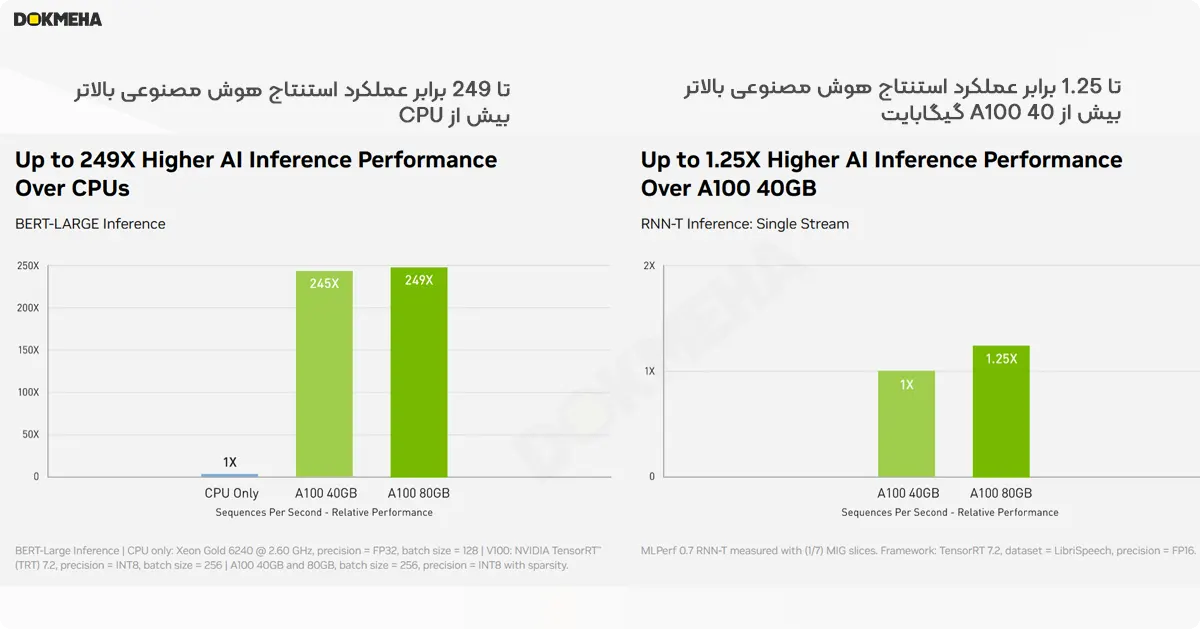

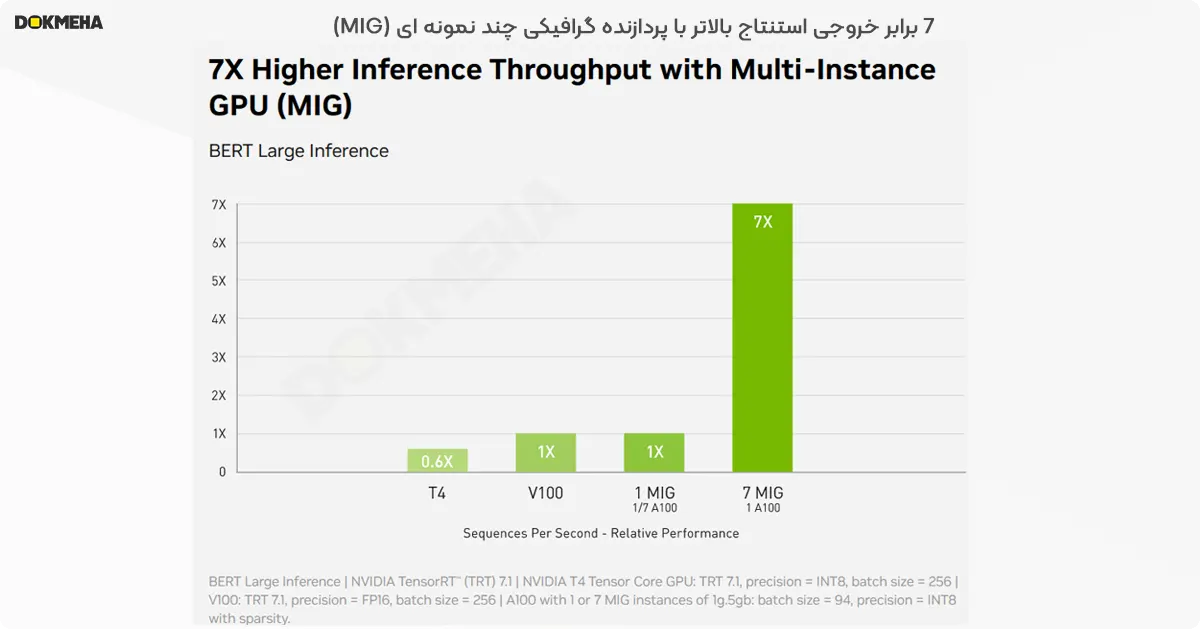

استنتاج یادگیری عمیق

پردازنده گرافیکی A100 با معرفی قابلیتهای پیشگامانه، بهینهسازی ویژهای را برای کارهای استنتاج یادگیری عمیق ارائه میدهد. این پردازنده قادر است دامنهی وسیعی از دقتها، از FP32 تا INT4 را تسریع کند. فناوری چندین نمونهی پردازنده گرافیکی (MIG) به چندین شبکه اجازه میدهد تا به طور همزمان روی یک A100 واحد کار کنند تا از منابع محاسباتی به شکل بهینه استفاده شود. همچنین، پشتیبانی از کمبود ساختاری، حداکثر تا ۲ برابر عملکرد بیشتر را به دستاوردهای دیگر A100 در زمینهی استنتاج اضافه میکند.

در مدلهای پیشرفتهی هوش مصنوعی مکالمهمحور مانند BERT، A100 توان عملیاتی استنتاج را تا ۲۴۹ برابر سریعتر از CPUها میکند.

در پیچیدهترین مدلهایی که با محدودیت اندازهی گروه (batch-size) مواجه هستند، مانند RNN-T برای تشخیص گفتار خودکار، A100 نسخهی ۸۰ گیگابایتی با افزایش ظرفیت حافظه، اندازهی هر MIG را دو برابر میکند و توان عملیاتی تا ۱.۲۵ برابر سریعتر از A100 نسخهی ۴۰ گیگابایتی ارائه میدهد.

عملکرد بیرقیب NVIDIA در MLPerf Inference به اثبات رسیده است. A100 با ۲۰ برابر عملکرد بیشتر، این پیشتازی را بیش از پیش افزایش میدهد.

۳. محاسبات با عملکرد بالا (HPC)

برای رسیدن به کشفیات نسل بعد، دانشمندان به سراغ شبیهسازیهایی میروند تا درک بهتری از دنیای اطرافمان به دست آورند.

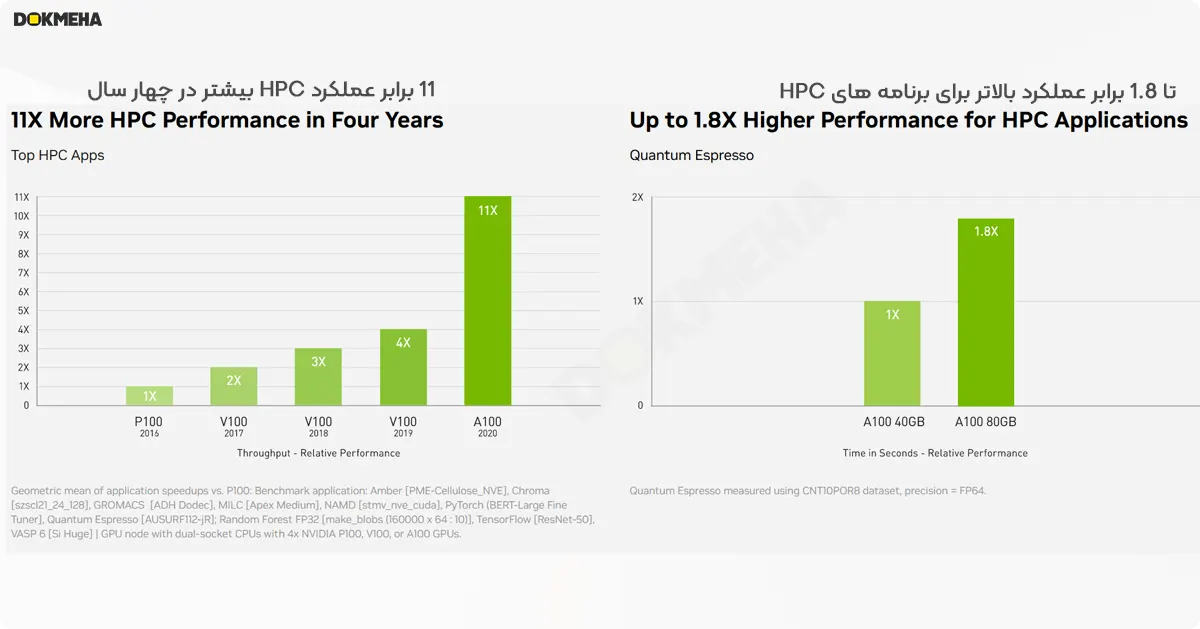

پردازنده گرافیکی A100 شرکت NVIDIA با معرفی هستههای تنسور با دقت دوگانه (double precision)، بزرگترین جهش در عملکرد HPC را از زمان معرفی پردازندههای گرافیکی ارائه میدهد. با ترکیب این فناوری با ۸۰ گیگابایت از سریعترین حافظههای GPU، پژوهشگران میتوانند یک شبیهسازی ۱۰ ساعته با دقت دوگانه را با A100 به کمتر از چهار ساعت کاهش دهند. همچنین، برنامههای کاربردی HPC میتوانند از TF32 برای دستیابی به حداکثر ۱۱ برابر توان عملیاتی بالاتر برای عملیات ضرب ماتریس متراکم تک-دقت (single-precision) بهرهمند شوند.

در مورد برنامههای کاربردی HPC با بزرگترین مجموعه دادهها، حافظهی اضافی A100 نسخهی ۸۰ گیگابایتی، توان عملیاتی را تا ۲ برابر با نرمافزار Quantum Espresso که برای شبیهسازی مواد استفاده میشود، افزایش میدهد. این حافظه عظیم و پهنای باند بیسابقهی حافظه، A100 نسخهی ۸۰ گیگابایتی را به سکوی ایدهآلی برای کارهای نسل بعد تبدیل میکند.

۴. تحلیل داده با عملکرد بالا

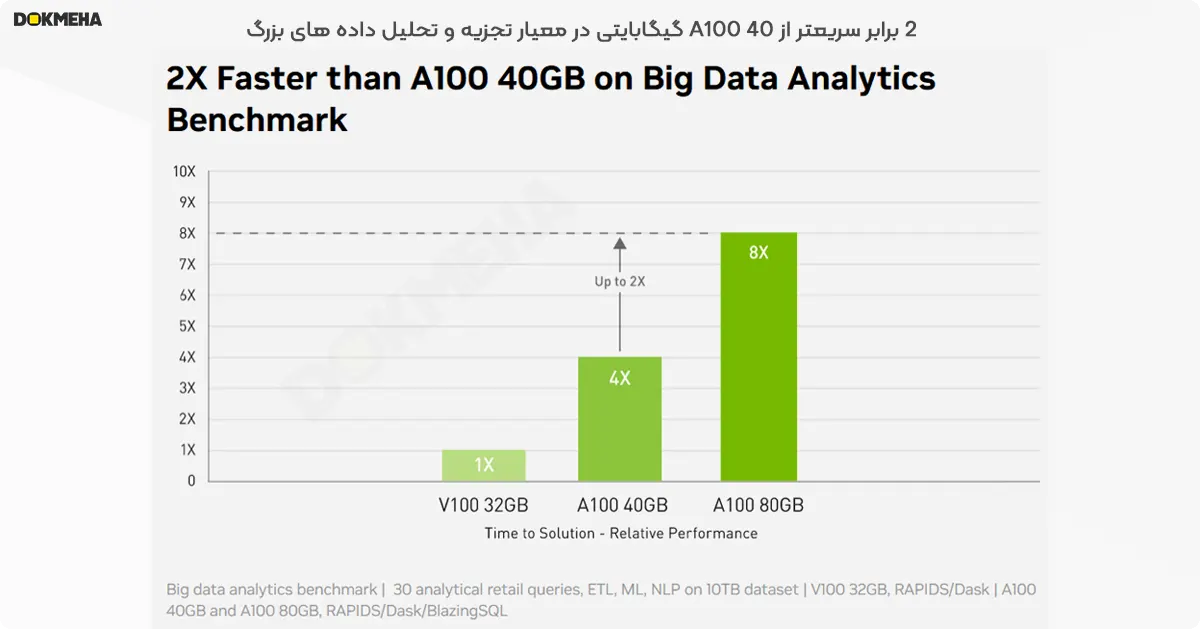

دانشمندان داده نیاز دارند تا بتوانند مجموعه دادههای عظیم را تحلیل، تجسم و به بینشهای کاربردی تبدیل کنند. اما راهحلهای مقیاسپذیر (scale-out) اغلب به دلیل پراکندگی مجموعه دادهها در سرورهای مختلف، با مشکل مواجه میشوند.

سرورهای مجهز به پردازندههای گرافیکی A100، قدرت محاسباتی مورد نیاز را به همراه حافظهی بسیار زیاد (بیش از ۲ ترابایت بر ثانیه پهنای باند حافظه)، قابلیت ارتقاء با NVIDIA NVLink و NVSwitch و در نهایت با ترکیب با InfiniBand، NVIDIA Magnum IO و مجموعهی کتابخانههای منبع باز RAPIDS شامل RAPIDS Accelerator برای Apache Spark جهت تحلیل دادههای شتابدهنده با GPU، در اختیار شما قرار میدهند. این پلتفرم مرکز دادهی NVIDIA، کارهای عظیم را با سطوح بیسابقهای از عملکرد و کارایی، تسریع میکند.

در یک بنچمارک تحلیلی کلانداده، A100 نسخهی ۸۰ گیگابایتی، تحلیلی با سرعتی ۲ برابر سریعتر از A100 نسخهی ۴۰ گیگابایتی ارائه داد که این امر، آن را برای کارهای نوظهوری که با انفجار اندازهی مجموعه دادهها مواجه هستند، ایدهآل میکند.

۵. بهرهبرداری سازگار با نیازهای سازمانی

پردازندهی گرافیکی A100 با فناوری MIG، میزان استفاده از زیرساختهای شتابدهندهی GPU را به حداکثر میرساند. با MIG، یک پردازندهی گرافیکی A100 را میتوان به حداکثر هفت بخش مستقل تقسیم کرد تا دسترسی چندین کاربر به شتابدهندهی GPU فراهم شود. در نسخهی ۴۰ گیگابایتی A100، هر بخش MIG میتواند تا ۵ گیگابایت حافظه اختصاص دهد و این مقدار با ظرفیت حافظهی بیشتر نسخهی ۸۰ گیگابایتی A100، تا دو برابر یعنی ۱۰ گیگابایت افزایش مییابد.

MIG با Kubernetes، containerها و مجازیسازی سرور مبتنی بر هایپرویزور سازگاری دارد. این فناوری به مدیران زیرساخت اجازه میدهد تا برای هر کار، یک پردازندهی گرافیکی با اندازهی مناسب و کیفیت خدمات تضمینشده (QoS) ارائه دهند و بدین ترتیب، دسترسی به منابع محاسباتی شتابدهنده را برای تمامی کاربران گسترش دهند.

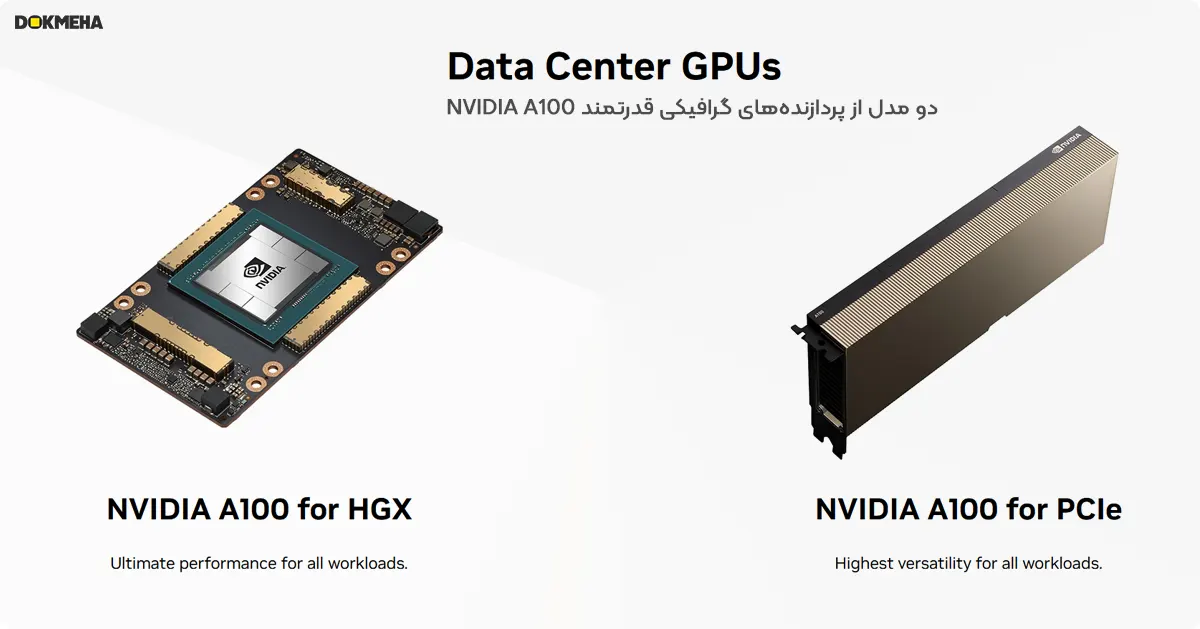

پردازندههای گرافیکی (GPU) برای مراکز داده

در نتیجه دو مدل از پردازندههای گرافیکی قدرتمند NVIDIA A100 وجود دارد:

- A100 برای HGX: این مدل برای بالاترین سطح عملکرد در تمامی کارها طراحی شده است. HGX مخفف “NVIDIA HGX” است که یک پلتفرم اختصاصی برای A100 با اتصالات پر سرعت است که امکان جابجایی بسیار سریع داده بین پردازندههای گرافیکی را فراهم میکند. این مدل برای کارهایی که نیازمند حداکثر قدرت محاسباتی هستند، مانند هوش مصنوعی (AI) پیشرفته و شبیهسازیهای علمی پیچیده، ایدهآل است.

- A100 برای PCIe: این مدل برای بالاترین انعطافپذیری در تمامی کارها ساخته شده است. PCIe مخفف “Peripheral Component Interconnect Express” است که یک رابط اتصال استاندارد برای سختافزارهای رایانهای است. این مدل A100 با طیف وسیعی از مادربردهای سرور سازگار است و راهاندازی آن سادهتر است. A100 برای PCIe همچنان یک پردازندهی گرافیکی بسیار قدرتمند است و برای بسیاری از کارها، از جمله یادگیری عمیق، تجزیه و تحلیل دادههای حجیم و محاسبات با کارایی بالا، مناسب است.

اطلاعات PDF پردازنده گرافیکی NVIDIA HGX A100

سرور گرافیکی NVIDIA HGX SXM5 A100 80GB 8xGPU

| کارایی و رده بندی | |

|---|---|

| برند و سری | |

| مدل | NVIDIA HGX SXM4 َA100 80GB 8-GPU |

| پردازنده گرافیک / Graphics Card | Release Date :November 16th, 2020 |

| پردازنده گرافیکی / Graphics Processor | GPU Name : GA100 |

| پیکربندی رندر / Render Config | Shading Units : 6912 |

| حافظه / Memory | Memory Size : 80GB x 8 = 640GB |

| سرعت اجرای پردازنده / Clock Speeds | Base Clock : 1275 MHz |

| عملکرد نظری / Theoretical Performance | Pixel Rate: 225.6 GPixel/s |

| ویژگی های گرافیک / Graphics Features | DirectX : N/A |

| شبکه سازی / Networking | 8x Single-Port Mellanox |

| پشتیبانی از تکنولوژیهای و ویژگی ها | PCI Express Gen 4 |

| طراحی برد / Board Design | Slot Width : SXM4 Module |

| گارانتی | دو ماه گارانتی رایگان دکمه ها Dokmeha, گارانتی طلایی 24 ماهه دکمه ها |

تعداد نظرات 0

اولین نفری باشید که نظری را برای “سرور گرافیکی NVIDIA HGX SXM4 A100 8-GPU” می نویسید.

لطفا برای نوشتن نظرات ابتدا وارد حساب کاربری شوید.

هنوز دیدگاه یا پرسشی ثبت نشده است.