تکنیک پراکندگی (Sparsity) در یادگیری ماشین: بهینهسازی محاسبات در مدلهای هوش مصنوعی و یادگیری عمیق

مقدمه

در دنیای یادگیری ماشین و پردازشهای دادهای، تکنیکهای متعددی برای بهینهسازی عملکرد مدلها و سرعت پردازش وجود دارد. یکی از مهمترین این تکنیکها، پراکندگی یا Sparsity است که در زمینههای مختلفی از جمله یادگیری عمیق (Deep Learning) و پردازش دادههای بزرگ نقش اساسی دارد. این تکنیک میتواند به طور قابل توجهی سرعت پردازش مدلهای یادگیری ماشین را افزایش دهد و در عین حال مصرف حافظه و انرژی را کاهش دهد. در این مقاله به بررسی مفهوم پراکندگی، انواع آن، مزایا و معایب، کاربردها، و چالشهای آن خواهیم پرداخت.

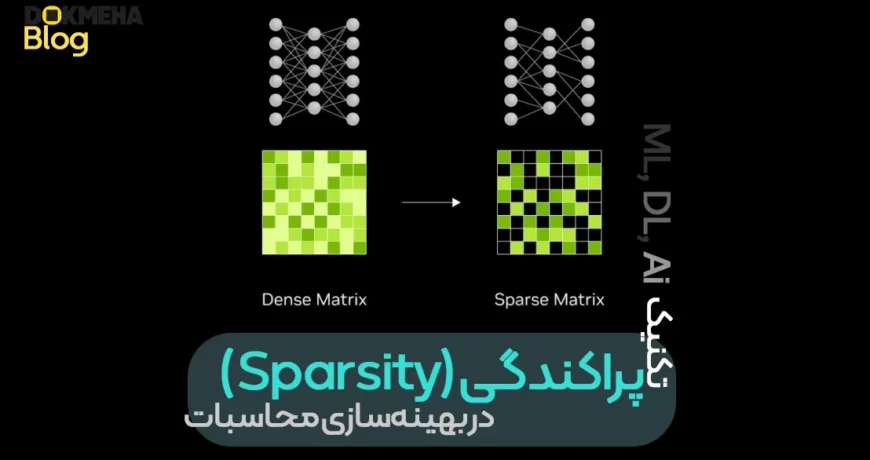

مفهوم پراکندگی (Sparsity) چیست؟

پراکندگی به وضعیتی اطلاق میشود که در آن بخش زیادی از مقادیر یک ماتریس یا بردار صفر هستند. این مفهوم به طور خاص در شبکههای عصبی مصنوعی (Artificial Neural Networks یا ANNs) و مدلهای یادگیری عمیق (Deep Learning Models) کاربرد دارد، جایی که در آن میتوان مقادیر صفر را از محاسبات حذف کرد تا پردازش سریعتر و بهینهتری داشته باشیم.

چرا پراکندگی مهم است؟

- کاهش عملیات محاسباتی: با حذف مقادیر صفر، تعداد محاسبات ریاضی لازم برای پردازش مدلها کاهش مییابد.

- افزایش سرعت پردازش: سختافزارهایی مانند کارتهای گرافیک (GPU) و واحدهای پردازش تنسور (Tensor Processing Units یا TPUs) میتوانند از پراکندگی برای انجام سریعتر محاسبات استفاده کنند.

- کاهش مصرف حافظه و انرژی: کاهش حجم دادههای ذخیرهشده و پردازششده به کاهش مصرف حافظه و انرژی منجر میشود. این امر به ویژه در پردازشهای بزرگ و مدلهای پیچیده اهمیت زیادی دارد.

انواع پراکندگی (Sparsity)

۱. پراکندگی غیرساختاری (Unstructured Sparsity)

در این نوع از پراکندگی، مقادیر صفر به صورت تصادفی در ماتریس یا بردار پراکنده میشوند. این روش انعطافپذیری بالایی دارد، اما چالشهایی در پردازش سریع آن وجود دارد زیرا سختافزارهای فعلی نمیتوانند از آن بهینه استفاده کنند.

مثال: فرض کنید وزنهای یک شبکه عصبی به صورت تصادفی صفر میشوند. در این حالت، پردازشها تنها با وزنهای غیرصفر انجام میشود، که باعث کاهش تعداد محاسبات میشود.

- مزایا: انعطافپذیری بالا، حذف دقیقترین وزنهای غیرضروری.

- معایب: پردازشها نامرتب میشوند و بهینهسازی سختافزارها برای این نوع پراکندگی محدود است.

۲. پراکندگی ساختاری (Structured Sparsity)

در این روش، مقادیر صفر به صورت بلوکها یا الگوهای مشخص حذف میشوند. این نوع پراکندگی به راحتی توسط سختافزارهای مدرن مانند GPU و TPU قابل استفاده است و میتواند سرعت پردازش را به طور قابل توجهی افزایش دهد.

مثال: در این روش، ممکن است از الگوی ۲:۴ استفاده شود. به این معنا که از هر چهار وزن، دو وزن صفر شده و حذف میشوند.

- مزایا: پردازش بهینهتر روی سختافزارهای مدرن، کاهش مصرف حافظه و افزایش سرعت.

- معایب: محدودیت در انعطافپذیری و احتمال حذف اطلاعات مهم.

چالشها و مشکلات استفاده از پراکندگی

۱. کاهش دقت مدل

یکی از مشکلات عمده در استفاده از پراکندگی، کاهش دقت مدل است. حذف وزنهای غیرضروری میتواند باعث از دست رفتن اطلاعات مهم شود. بهویژه در پراکندگی غیرساختاری (Unstructured Sparsity)، که در آن مقادیر صفر به صورت تصادفی حذف میشوند، خطر از دست رفتن ویژگیهای مهم بیشتر است.

۲. چالشهای پیادهسازی

پیادهسازی پراکندگی بهویژه در مدلهای پیچیدهای مانند مدلهای زبان بزرگ (مانند GPT و BERT) ممکن است با چالشهایی روبرو باشد. این مدلها به دلیل پیچیدگیهای زیاد خود، ممکن است نتایج مطلوبی از بهینهسازی پراکندگی نداشته باشند.

۳. انتخاب بین پراکندگی ساختاری و غیرساختاری

برای انتخاب بهترین نوع پراکندگی، باید به ویژگیهای پروژه توجه کرد. اگر مدلهای بزرگ با دادههای پیچیده در دسترس هستند و سختافزار پیشرفتهای مانند GPU یا TPU موجود است، استفاده از پراکندگی ساختاری بهترین گزینه خواهد بود. اما اگر نیاز به دقت بالا دارید و انعطافپذیری بیشتری میخواهید، ممکن است پراکندگی غیرساختاری انتخاب بهتری باشد.

کاربردهای عملی پراکندگی

پراکندگی تنها به یادگیری ماشین محدود نمیشود و در صنایع مختلف نیز کاربردهای وسیعی دارد. برخی از این کاربردها شامل:

۱. صنایع خودروسازی

در خودروسازی، از پراکندگی برای بهینهسازی پردازش دادهها در سیستمهای پیشرفته رانندگی خودکار و شبیهسازیهای پیچیده استفاده میشود. با استفاده از تکنیکهای پراکندگی، پردازشهای مربوط به حسگرهای خودروها سریعتر و بهینهتر انجام میشود.

۲. پزشکی

در پردازش تصاویر پزشکی و پیشبینی بیماریها، پراکندگی میتواند به کاهش مصرف حافظه و انرژی کمک کند، بهویژه در دستگاههایی که منابع محدود دارند. به این ترتیب، میتوان مدلهای پیشرفتهتری را در محیطهای پزشکی به کار برد.

۳. تحلیل دادههای مالی

در تحلیل دادههای مالی و پیشبینیهای بازار، پراکندگی میتواند پردازش دادههای بزرگ را سریعتر کند و به تصمیمگیریهای سریعتر در زمانهای حساس کمک نماید.

پیشرفتهای اخیر در فناوری سختافزاری و نرمافزاری

در سالهای اخیر، تکنولوژیهای NVIDIA Ampere و Tensor Cores به عنوان پیشرفتهترین سختافزارهای پردازشی برای بهبود کارایی مدلهای پراکنده معرفی شدهاند. این معماریهای سختافزاری بهویژه در پردازشهای یادگیری عمیق و تحلیل دادههای بزرگ، عملکرد بسیار بالایی از خود نشان دادهاند.

۱. Tensor Cores در NVIDIA

با استفاده از Tensor Cores در معماریهای NVIDIA Volta و Ampere، قابلیتهای جدیدی در پردازشهای پراکنده برای مدلهای یادگیری ماشین و هوش مصنوعی ایجاد شده است. این هستهها بهطور خاص برای عملیات ماتریسی بهینهسازی شدهاند و میتوانند سرعت پردازش را تا دو برابر افزایش دهند.

۲. TPU در Google

TPUs (Tensor Processing Units) نیز از فناوری پراکندگی ساختاری پشتیبانی میکنند و بهطور خاص برای مدلهای یادگیری عمیق مانند BERT و GPT طراحی شدهاند.

نتایج تجربی و مقایسههای دقیقتر

آزمایش اول: مقایسه عملکرد Sparse و Dense در مدلهای CNN

- مدل: ResNet-50

- نتایج آزمایش:

- Dense: سرعت پردازش ۲۰۰ میلیثانیه و دقت ۷۶.۵%.

- Sparse (50%): سرعت پردازش ۱۲۰ میلیثانیه و دقت ۷۵.۸%.

این آزمایش نشان میدهد که حذف ۵۰٪ از وزنها باعث افزایش سرعت پردازش به دو برابر شده است و تنها کاهش اندکی در دقت مدل مشاهده میشود.

آزمایش دوم: تاثیر Sparsity در مدلهای Transformer (مانند GPT-3 و LLaMA)

- مدل: LLaMA-7B

- نتایج آزمایش:

- Dense: زمان تولید ۴.۵ ثانیه، مصرف حافظه 30GB.

- Sparse (2:4): زمان تولید ۲.۳ ثانیه، مصرف حافظه 20GB.

نتایج این آزمایش نشاندهنده افزایش سرعت استنتاج و کاهش قابل توجه مصرف حافظه است که به ویژه برای پردازش مدلهای بزرگ بر روی دستگاههای با منابع محدود حائز اهمیت است.

جمعبندی

پراکندگی یک تکنیک بهینهسازی قدرتمند است که میتواند سرعت پردازش مدلها را تا دو برابر افزایش داده و مصرف حافظه و انرژی را کاهش دهد. با پیشرفتهای سختافزاری مانند NVIDIA Tensor Cores و Google TPU، استفاده از پراکندگی در مدلهای یادگیری عمیق مانند GPT و BERT به استانداردی در پردازش دادههای بزرگ و پیچیده تبدیل شده است. همچنین، کاربردهای این تکنیک در صنایع مختلف از جمله خودروسازی، پزشکی و تحلیل دادههای مالی بسیار چشمگیر است.

استفاده از پراکندگی در پروژههای یادگیری ماشین و هوش مصنوعی میتواند به نتایج بسیار بهینهتری در پردازش دادههای بزرگ و پیچیده منجر شود.